Seja bem-vind@ à disciplina ARQ5102 – Introdução prática à Ciberarqueologia: Modelagem 3D e Interatividade em tempo real ministrada por mim, Alex Martire, no Programa de Pós-Graduação em Arqueologia do Museu de Arqueologia e Etnologia da USP (mais conhecido como MAE).

Se você chegou até aqui, meus parabéns! Isso mostra o quão corajoso o seu espírito é a ponto de ter se matriculado nessa disciplina (afinal, vamos falar sobre Cibernética em um curso de Arqueologia). Espero que não se arrependa e que, principalmente, possa extrair coisas boas de nossas conversas para a sua própria pesquisa.

Aula 1 (Teoria) – A Cibernética antes da Cibernética: o perigo vem do céu

O que vem a sua mente quando escuta a palavra Cibernética?

Acredito que deva ter pensado em ao menos uma das duas opções: computadores ou robôs. O imaginário ao redor da cibernética é muito grande e sempre podemos ouvir algo relacionado ao tema em filmes, séries ou livros. “Soldado cibernético”, “crime cibernético”, “mundo cibernético”… algumas dessas palavras são quase “algo dado”, uma vez que as ouvimos ou reproduzimos com certa frequência. Contudo, o que é essa tal de cibernética? Por que ela está presente em nosso vocabulário e é quase um sinônimo de “coisas de computador” ou máquinas inteligentes/robôs? Ao longo deste curso vamos tentar responder essa questão. Digo “tentar” pois, como veremos, as conceituações variaram de década para década, desde os anos 1940 até hoje. E, além de definirmos, vamos, também, relacionar a cibernética com a arqueologia, para mostrar que a Ciberarqueologia não é meramente o “uso de computadores na pesquisa arqueológica” (mesmo que fosse, os computadores, por si próprios, são seres cibernéticos).

A cibernética é algo fascinante. É o modo como nos comunicamos com as máquinas, e elas, conosco. Escrevo esse texto graças à cibernética, e você o lê também graças a ela. Seria ela “onipresente”, “onisciente”, o ser que comanda nossas vidas? Bem, talvez seja uma questão de como encarar as coisas e, não duvido, no futuro teremos devotos de deus-máquinas (poderíamos começar pela Google, não é? Afinal, estamos tão dependentes dela…) tal como vemos em algumas obras literárias ou jogos eletrônicos como Deus Ex: Mankind Divided (recomendo que veja o vídeo abaixo, é muito bom e lida com o lado do “culto” à tecnologia!)

A “invenção” da Cibernética é comumente atribuída ao matemático estadunidense Norbert Wiener, que publicou seu livro sobre esse tema na década de 1940. Estranhamente (para o dizer o mínimo), Wiener em nenhum momento de sua obra cita toda a gama de trabalhos realizados anteriormente que, de fato, já lidava com a cibernética. Trabalhos esses, ligados às Forças Armadas dos EUA e da Grã-Bretanha.

<Acréscimo versão 2019>

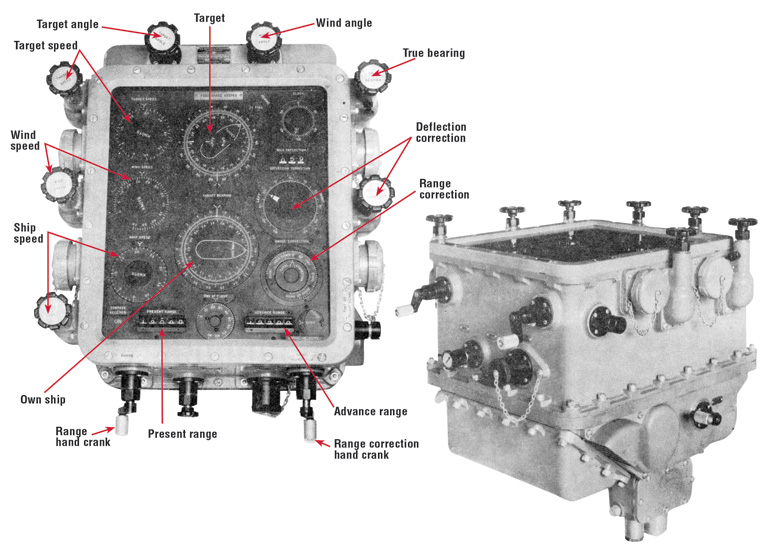

Atingir navios de batalha inimigos que navegam mudando sempre sua direção e velocidade não é tarefa fácil: existem cálculos complexos por detrás dos disparos contra inimigos e, para piorar, esses cálculos devem ser feitos no calor da batalha. Assim, não é difícil imaginar que a batalha naval durante o início da Primeira Guerra Mundial (1914-1918) foi bastante baseada em tentativas e erros, pois ainda não haviam dispositivos confiáveis que facilitassem a vida dos operadores de artilharia no cálculo de mira. Porém, em julho de 1916, o jovem inventor e empresário Hannibal Ford, fundador da Ford Instrument Company em 1915 após sair da empresa Sperry Gyroscope, mostrou aos tenentes do navio USS Texas a sua nova ideia: um sistema mecanizado de cálculos inserido em um dispositivo físico denominado rangekeeper (“sustentador de alcance”, em tradução livre). O protótipo foi muito bem aceito entre os militares, que escreveram um relatório ao Bureau of Ordnance (BuOrd) da Marinha solicitando um contrato – no mês seguinte, a empresa de Ford cotou um preço de $100.000 à Marinha para entregar nove dispositivos rangekeeper dentro de oito a dez meses. Desse modo, a Ford Instrument Company, uma empresa privada, se tornou uma das primeiras companhias a trabalhar com sistemas de controle de fogo dentro das Forças Armadas estadunidenses, juntamente com as empresas Sperry Gyroscope (mais tarde, Sperry Corporation), General Electric (G.E.) e Arma Engineering Company.

Os sistemas de controle de fogo tinham de resolver a questão de mirar uma arma desmembrando-a em três aspectos: percepção (olhar através do visor), integração (estimar a trajetória do alvo), e articulação (apertar o gatilho). A percepção se refere a como um sistema de controle apre(e)nde o mundo, como o enxerga: exemplos de instrumentos de percepção são os telescópios e os telêmetros (rangefinders), que coletam dados do ambiente e do inimigo e os converte para números. A integração está relacionada à memória, ou seja, armazenamento de dados após prévio processamento e filtragem de sinais. Por fim, a articulação se refere à saída (output) do sistema, efetuando uma ação concreta (como a de pressionar um gatilho para disparar a arma). O rangekeeper desenvolvido por Ford, denominado Mark 1, lidava com a resolução desses problemas em conjunto e foram vendidos à Marinha dos EUA por $8.000 cada (pouco depois, a companhia desenvolveu uma versão mais barata do dispositivo, chamada Mark 2, ou “Baby Ford”). A produção e a venda, contudo, eram secretas, e a Ford Instrument Company era proibida de trabalhar para quaisquer outros potenciais clientes (civis ou militares de outras nações).

Há poucas fotografias do Mark 1 disponíveis, porém, o Mark 7, da década de 1930, nos dá uma boa ideia de como era a aparência e funcionalidade do primeiro modelo (note que todas as entradas de variáveis eram feitas por manivelas). In: https://www.usni.org/magazines/naval-history-magazine/2015/october/armaments-innovations-revolutionary-rangekeeper

Mark 2: versão mais barata do Mark 1. Também denominado “Baby Ford”. In: https://www.usni.org/magazines/naval-history-magazine/2015/october/armaments-innovations-revolutionary-rangekeeper

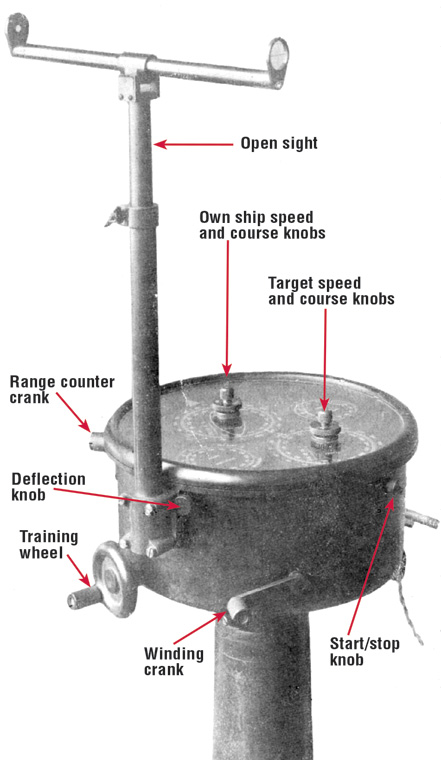

Em 1918, outra empresa foi sondada pelo BuOrd, a General Electric (G.E.), conhecida na época como líder em pesquisa industrial e tecnologia eletrônica de ponta. Embora não tivesse experiência anterior em controle de fogo, a G.E. ficou responsável por desenvolver um dispositivo síncrono para ser utilizado em navios de guerra. Entre 1918 e 1920, o engenheiro Edward Hewlett desenvolveu um novo sistema de controle de fogo construído ao redor de um motor auto-síncrono denominado “Selsyn“: esse sistema utilizava corrente alternada (CA, ou AC, em inglês) ao invés de corrente contínua (CC, ou DC, em inglês) para transmitir posição rotacional sobre uma distância através de três fios. Em 1920, o sistema foi implementado nos navios de guerra USS Colorado e USS Maryland. Assim como a solução da Ford, os sistemas síncronos da G.E. tiveram sucesso porque transmitiam dados sem corrupção, permitindo cálculos ainda mais complexos.

Princípio de funcionamento do motor síncrono da G.E. In: David A. Mindell, Between human and machine. Feedback, control, and computing before Cybernetics, p. 49.

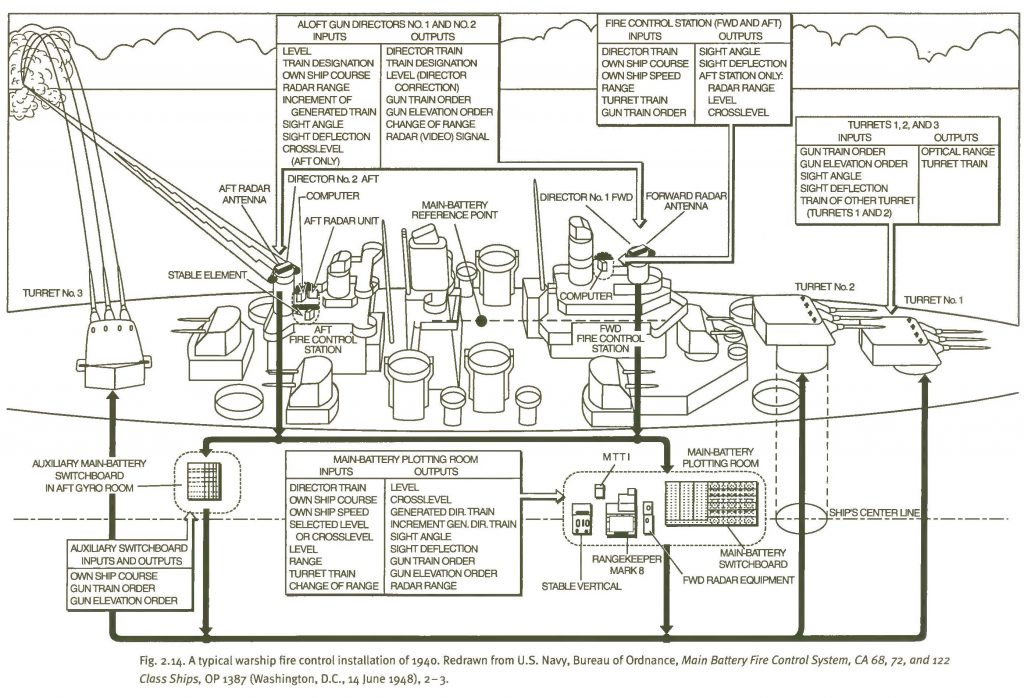

Caso tenha interesse em saber como era a instalação de um controle de fogo em navios, a figura abaixo é bastante didática:

In: David A. Mindell, Between human and machine. Feedback, control, and computing before Cybernetics, p. 58.

Os dispositivos criados pelas companhias que tinham contratos com as Forças Armadas estadunidenses foram bem sucedidos no campo da batalha naval: agora era possível fazer o rastreamento dos navios inimigos com precisão e acertá-los à distância dentro de um número aceitável de acertos. Os navios, contudo, ainda enfrentavam um grande problema, dessa vez, vindo do céu: os aviões.

</Acréscimo versão 2019>

Falar sobre a cibernética pré-Wiener é falar sobre a empresa Sperry Corporation, fundada em 1910 por Elmer Ambrose Sperry no Brooklyn, em Nova Iorque (EUA). A Sperry Corporation foi uma das principais empresas privadas que auxiliaram as Forças Armadas durante as duas Guerras Mundiais (ao lado da IBM e da RCA). Tendo como foco a produção de equipamentos bélicos, a Sperry atuou em 3 segmentos: 1) produção de pilotos automáticos para navios; 2) produção de pilotos automáticos para aeronaves; 3) sistemas de controles de artilharia antiaérea. A relação entre o governo estadunidense e a Sperry se dava da seguinte maneira: durante os tempos de paz, o governo permitia à Sperry a experimentação de tecnologias de risco e, durante a guerra, exigia (e financiava) produção em larga escala de equipamentos bélicos. O desenvolvimento de pilotos automáticos para aeronaves, por exemplo, auxiliou no controle das máquinas durante os vôos, pois o piloto podia reduzir sua fadiga em momentos de trabalho extremo ou estresse: o dispositivo atuava controlando a direção e altitude do avião, e o piloto apenas controlava esse dispositivo – em outras palavras, acontecia um laço de feedback (retroalimentação) entre o piloto (que “dizia” à máquina o que fazer) e o avião (que ajustava as coordenadas de acordo com aquilo que o piloto pedia).

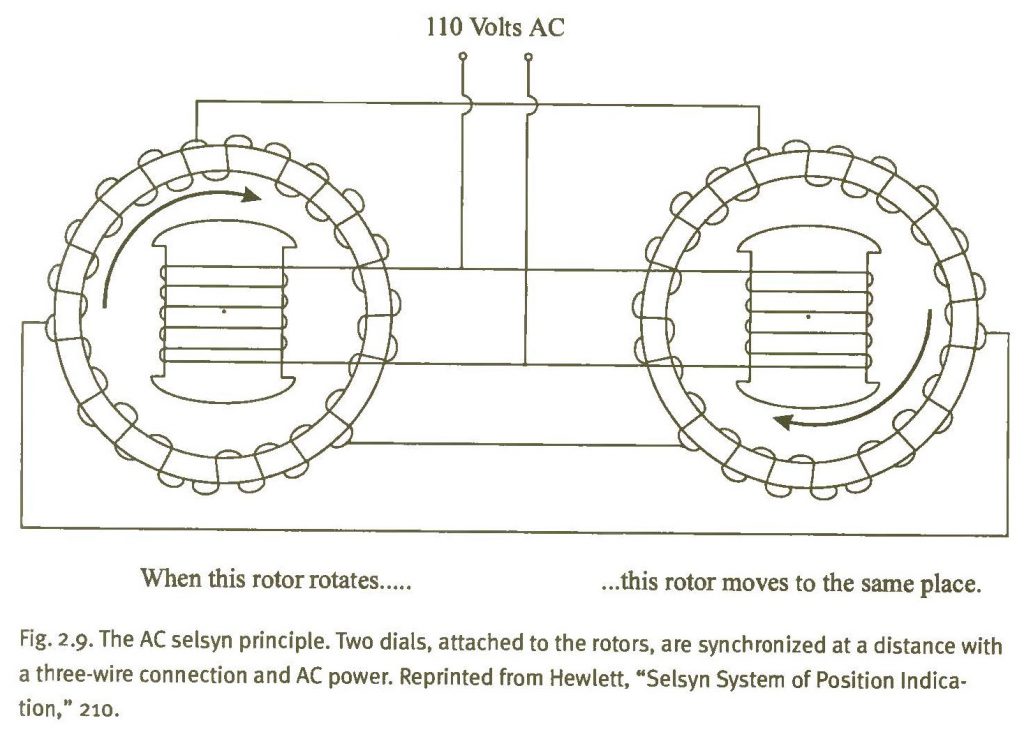

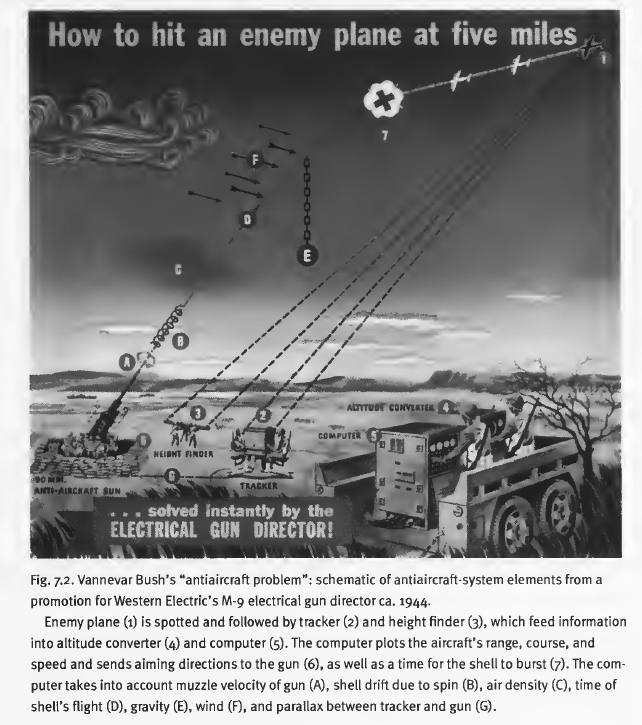

O governo dos EUA, contudo, não estava interessado apenas na automatização da pilotagem: era essencial que, do solo, os soldados pudessem abater os aviões inimigos – para tanto, saber o posicionamento futuro do avião era primordial. Era como caçar patos: o caçador precisa estabelecer a trajetória da ave para atirar não onde ela está, mas, sim, onde ela estará. Esse problema da “caça aos patos” era amplificado devido à velocidade e altitude das aeronaves durante o combate. Havia, então um loop de feedback: a predição só poderia ser alcançada quando o tempo do voo fosse sabido, mas o tempo do voo dependia do ponto de mira da artilharia antiaérea que, por sua vez, era um output (saída) da predição (em outras palavras, uma coisa alimentava a reação da outra). Em 1930, após alguns protótipos, a Sperry desenvolveu o preditor denominado T-6, um computador que calculava a predição (ou seja, o local onde a aeronave inimiga estará no tempo) e a balística (ou seja, como mirar a arma de modo que a cápsula lançada exploda no momento exato em um ponto no espaço e tempo). Desse modo, a predição e a balística formavam um laço de feedback: os operadores inseriam no preditor dados referentes ao tempo estimado de viagem da cápsula quando avistavam o inimigo; o preditor usava esses dados para enviar cálculos iniciais ao estágio da balística que, por sua vez, refazia os cálculos e retornava a informação atualizada sobre o tempo de voo estimado ao preditor, permitindo o disparo preciso.

Esquema de elementos presentes em um sistema antiaéreo (note como o disparo e a detonação da munição não seguiam a mesma trajetória do avião inimigo). In: David A. Mindell, Between human and machine. Feedback, control, and computing before Cybernetics, p. 204.

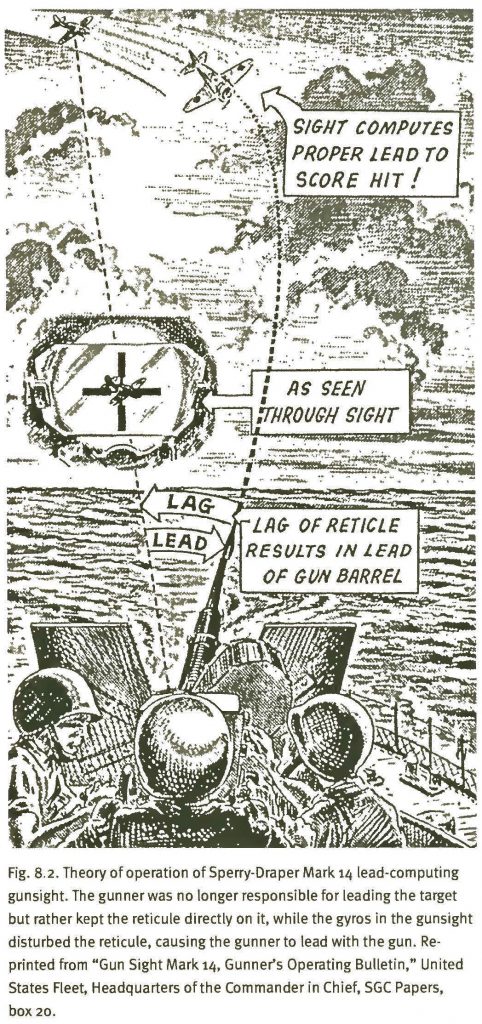

O desenvolvimento da tecnologia antiaérea fez com que houvesse mudanças no modo como os alvos eram rastreados: enquanto o artilheiro mirava o avião inimigo em seu visor (terrestre ou naval), a torreta ajustava-se automaticamente para o local em que o avião estaria no futuro (ocorrendo, então, um lag, ou seja, atraso). In: David A. Mindell, Between human and machine. Feedback, control, and computing before Cybernetics, p. 204.

Esse vídeo deixa o assunto sobre predição e balísitca um pouco mais claro:

O papel da Sperry Corporation foi fundamental durante a Segunda Guerra Mundial (1939-1945) não apenas no solo: para elaborar armas adaptáveis aos aviões estadunidenses, a empresa contratou, em 1940, o imigrante italiano pintor de afrescos e murais Alfred Crimi, que se tornou responsável pelo design da maioria dos equipamentos da Sperry, incluindo as torretas duplas do avião B-17, posicionadas em uma esfera que girava sobre seu próprio eixo. As ilustrações de Crimi são excepcionalmente belas, como pode ver abaixo:

Em 1942, a empresa Sperry Corporation assinou contrato junto às Forças Armadas para produzir mais de um bilhão de dólares em sistemas de controle. Em 1943, o número de empregados da Sperry chegou a 32 mil pessoas. Entre 1942 e 1945, o valor dos produtos da empresa somaram mais de 1.3 bilhões de dólares.

Para além da artilharia antiaérea da Sperry, outra inovação se mostrou fundamental durante a Segunda Guerra Mundial. Em 1940, os melhores sistemas de radares não eram bons o bastante automatizar o controle de fogo contra um avião inimigo (o NDRC, National Defense Research Committee, fundado pelo presidente Franklin Delano Roosevelt em 27 de junho do mesmo ano) começou a investir para mudar essa situação). RADAR significa radio detection and ranging (detecção e localização por rádio), e seu objetivo principal era determinar distância de um objeto no espaço da estação de radar. Até 1940, os radares dos Aliados e do Eixo operavam com ondas largas, fazendo com que a resolução transmitida pelas antenas fosse muito baixa, uma vez que a distância medida era muito espaçada. Os ataques aéreos alemães aos ingleses fizeram com que os pesquisadores da Universidade de Birmingham, em 1939, desenvolvessem o magnetron de múltiplas cavidades (cavity magnetron). O magnetron passou a ser usado nos radares pois conseguia produzir ondas curtas de 10 centímetros ou até mesmo 3 cm: além de aumentar a resolução de detecção de inimigos, o magnetron permitia, graças ao seu tamanho diminuto, a mobilidade dos radares.

<Acréscimo versão 2019>

É interessante aprofundar a questão dos radares, uma vez que foram decisivos durante a Segunda Guerra Mundial e, atualmente, estão presentes em todos os controles aéreos de tráfego ao redor do mundo. Em 1941, embora os navios de guerra estadunidenses estivessem equipados com as artilharias produzidas, principalmente, pela Sperry Corporation, um ataque inimigo foi capaz de fazer com que as Forças Armadas dos EUA repensassem suas estratégias: os Kamikazes (ou camicases) japoneses eram ataques suicidas rápidos, baixos e imprevisíveis. Causar danos a um avião Kamikaze próximo ao navio de guerra não significava muito, uma vez que ele iria se chocar contra o navio do mesmo modo. Assim, era necessário abater o avião a uma distância segura. Para isso, era preciso desenvolver a tecnologia de radares móveis.

Um pouco antes do ataque Kamikaze à baía naval de Pearl Harbor em 1941, o engenheiro graduado pelo MIT Horatio Rivero foi contratado pelo BuOrd (1940) para liderar, juntamente com Samuel Tucker (o cunhador do termo radar), a equipe de desenvolvimento de tecnologia de radares. Utilizando o recém-importado magnetron britânico, a equipe de Rivero produziu alguns resultados que auxiliaram os estadunidenses na guerra, mas que ainda estavam muito aquém do desejado nos quesitos velocidade e “tiro cego” (ou seja, o radar controlando diretamente as armas para atirar automaticamente durante a noite ou durante neblinas.

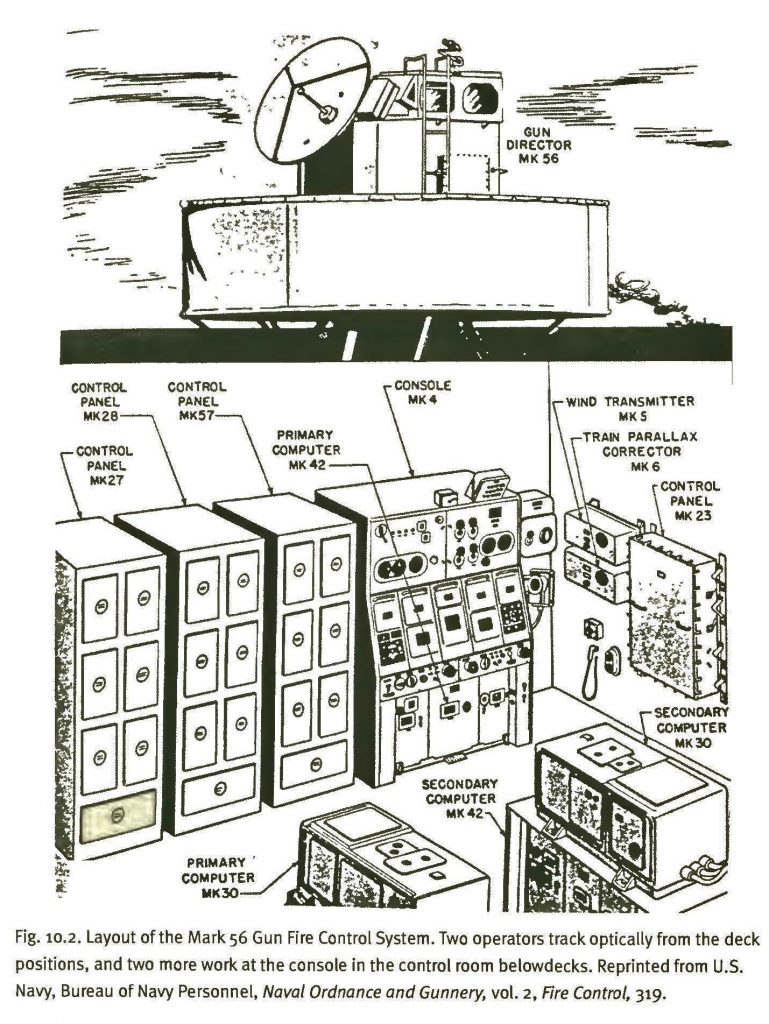

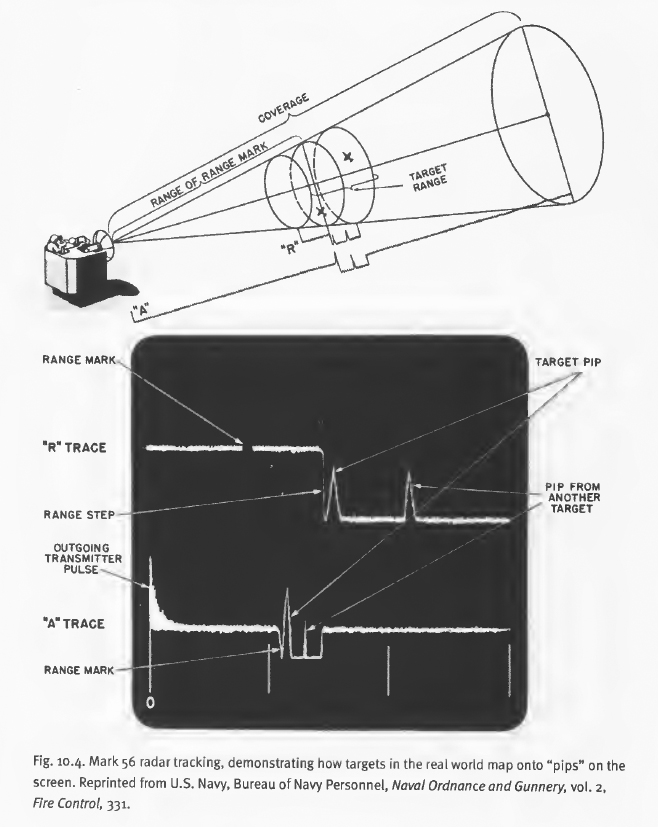

Essa situação só começou a mudar em 1943, quando o Laboratório de Radiação do MIT iniciou o programa de desenvolvimento do sistema de controle de fogo Mark 56, um dos últimos contratos do NDRC para esse tipo de dispositivo. O seu radar de escâner cônico com 3 cm de comprimento de onda conseguia buscar, em uma área significativa, por alvos e, ao mesmo tempo, automaticamente rastreá-los, até mesmo em ângulos baixos. Eram necessários dois operadores no diretor no deque para fazer o rastreamento óptico e direcionarem a antena do radar: o processamento dessas variáveis era realizado em um compartimento abaixo do deque. O Mark 56 fazia todos os cálculos em um conjunto interno com um giroscópio que rastreava a linha de visão, enquanto o diretor em si, no deque, era movido por um servomecanismo. Embora bastante avançado tecnologicamente, o Mark 56 nunca chegou a ser utilizado na Segunda Guerra devido ao seu tempo de desenvolvimento. Os primeiros Mark 56 só chegaram à frota estadunidense em 1947, porém, só foram amplamente utilizados (e se tornaram padrão) nos navios da Marinha dos EUA na década de 1970.

Detalhes de elementos e operação do Mark 56. In: David A. Mindell, Between human and machine. Feedback, control, and computing before Cybernetics, pp. 269, 271.

Quer saber o que havia dentro de um Mark 56? Assista a esse vídeo (note os servomecanismos dentro do dispositivo – o monte de eixos e engrenagens que faziam o trabalho mecânico antes dos componentes eletrônicos):

Para ver os equipamentos em ação, basta rodar o vídeo a seguir:

Os radares móveis também foram utilizados pelo Exército estadunidense durante a Segunda Guerra Mundial. Em 1940, o rastreamento com radar ainda era uma atividade manual: o operador via o dado em uma tela de osciloscópio e utilizava um apontador eletrônico, controlado por um volante, para selecionar o eco no radar que deveria ser o alvo – cabia, assim, aos operadores humanos a filtragem daquilo que era o sinal verdadeiro do inimigo em meio aos ruídos captados pelo radar. Para driblar esse problema, o Laboratório de Radiação do MIT começou a trabalhar em meios de automatizar o rastreamento a fim de eliminar a necessidade de um operador, manualmente, ter de identificar na tela os “pips” advindos dos inimigos.

Para substituir os “pips”, foi desenvolvido um escaneamento cônico, ou seja, a rotação da emissão do radar ao redor do eixo da antena 30 vezes por segundo, formando um cone. Essa emissão giratória podia detectar quando um alvo saia de seu centro e, assim, enviava um sinal de feedback para a antena reposicionar o alvo em seu centro novamente (em outras palavras, a antena conseguia rastrear alvos que se moviam, como aviões). Para movimentar rapidamente a antena, o laboratório do MIT adquiriu servomecanismos da empresa G.E. e, em 1941, realizou, com sucesso os primeiros testes de rastreamento em Boston. Com o aparato funcionando bem, os engenheiros montaram todo o dispositivo sobre um caminhão, para tornar o radar móvel: isso também protegia os operadores de ataques inimigos, bem como das mudanças climáticas que podem ocorrer durante campanhas de batalhas. Esse caminhão foi denominado XT-1.

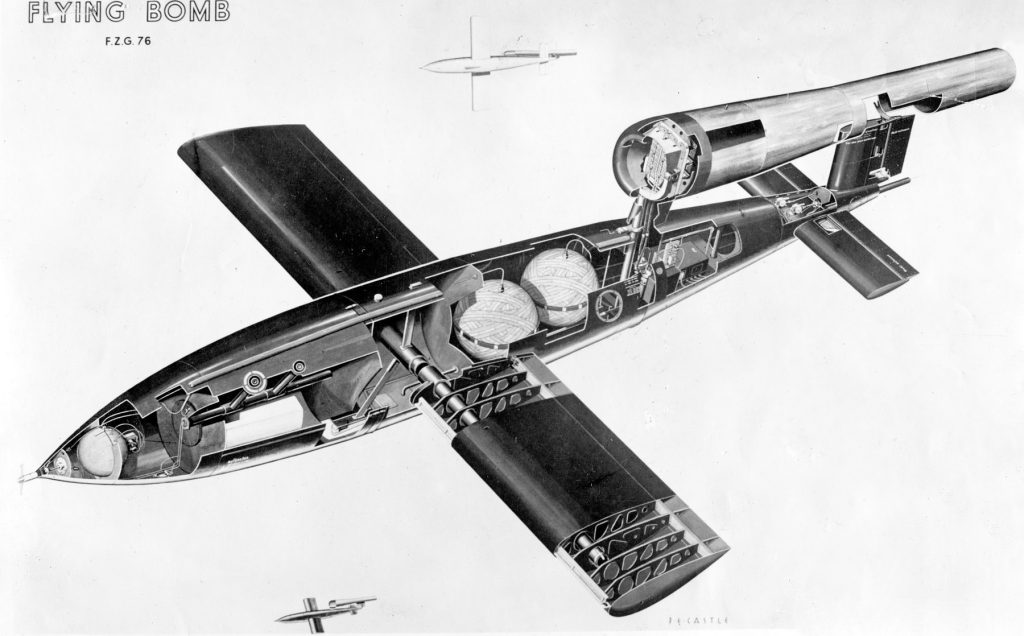

O sucesso do XT-1 logo fez com que o Exército o padronizasse como o sistema de radar SCR-584, encomendando mais de mil unidades, custando cada uma cerca de $100.000 e pesando 10 toneladas (o sistema era montado em um trailer). Quando chegou aos campos de batalha, o radar trabalhou muito bem: quando um alvo era identificado, o radar conseguia rastreá-lo com acurácia dentro de um raio de 18 milhas (aproximadamente 29 quilômetros). O SCR-584 também foi decisivo para as batalhas em território europeu. Os alemães haviam desenvolvido a “bomba robô” denominada V-1, uma bomba com controle automático de voo que emulava, em sua forma, um pequeno avião. A Alemanha bombardeou Londres, a partir da costa francesa, em junho de 1944, logo após o Dia D, com quase 7.500 bombas V-1. As Forças Armadas britânicas pediram auxílio aos EUA, que enviaram a tecnologia do SCR-584, além de treinamento para os operadores. Surtiu efeito: entre 18 de junho e 17 de julho de 1944, as armas automatizadas pelo SCR-584 derrubaram 343 V-1’s (cerca de 10% do total do ataque).

Interior de uma bomba V-1. In: https://en.wikipedia.org/wiki/V-1_flying_bomb

Mesmo bem-sucedido, o SCR-584 apresentava suas limitações. Ele dependia muito de operadores bem treinados para lidar com o rastreamento óptico, uma vez que nem sempre o radar conseguia filtrar os sinais dos alvos de outros ruídos vindos das redondezas ou de alvos muito próximos. Além disso, o radar e os visores ópticos eram montados em diferentes equipamentos: enquanto os radares ficavam dentro do trailer, os rastreadores ópticos ficavam do lado de fora.

Para saber mais sobre os radares de guerra, fica a dica:

</Acréscimo versão 2019>

Leitura recomendada

› MINDELL, David A.. Between human and machine. Feedback, control, and computing before Cybernetics. Baltimore/London: The Johns Hopkins University Press, 2002.

O capítulo 3, intitulado “Taming the beasts of the Machine Age. The Sperry Company”, oferece uma base excelente sobre a atuação da Sperry Corporation junto às Forças Armadas estadunidenses antes e durante a Segunda Guerra Mundial. O capítulo aborda algumas questões técnicas muito interessantes sobre o funcionamento dos sistemas de pilotagem automática e preditores.

› RID, Thomas. Rise of the machines. A cybernetic history. New York: W. W. Norton & Company, Inc., 2016.

O capítulo 1, intitulado “Control and communication at war”, oferece um panorama sobre a cibernética pré-Wiener. É um texto mais geral, não focando apenas na Sperry Corporation, incluindo algumas inovações britânicas durante o período da Segunda Guerra Mundial.

› Radar Operator’s Manual (RADTHREE), Radar Bulletion n. 3. Washington DC: United States Fleet, Navy Department, 1945.

Esse é para os fortes! O manual apresenta os princípios gerais de funcionamento dos radares e também descreve em pormenores os elementos técnicos de um radar.

Acesse aqui: https://www.ibiblio.org/hyperwar/USN/ref/RADTHREE/index.html

Jogo recomendado

Falamos sobre Cibernética… Falamos sobre as torretas automatizadas do avião B-17… Que tal juntarmos tudo isso na prática?!

B-17 Flying Fortress: The Mighty 8th é um simulador lançado em 2000 para computadores. A curva de aprendizado é um pouco longa, mas vale a pena.

Filme recomendado

Acredito que um dos melhores filmes sobre essa época de guerras e cibernética seja a cinebiografia de Alan Turing O Jogo da Imitação (The Imitation Game), dirigido por Morten Tyldum em 2014. Computadores são realmente fascinantes, não acha?!

Aula 2 (Teoria) – Caça os patos! A importância do feedback na construção da Cibernética

Nessa aula falaremos, finalmente, sobre Cibernética!

Sei que você não se aguentava mais de ansiedade e que passou noites em claro esperando por esse momento. Pois bem, aqui estamos: vamos caçar patos!

Se tiver a minha idade, provavelmente, jogou Duck Hunt para o Nintendinho (ou, como foi comum aqui no Brasil, em algum videogame “genérico”, similar a ele). Caçar os patos no jogo é um problema de antecipação de posição do alvo: temos de ler a trajetória da ave na tela e “adivinharmos” em que local ela estará no futuro – desse modo, miramos a arma de brinquedo não onde o pato está, mas, sim, onde ele supostamente estará. Tratando-se de caça real, o caçador experiente observa o pato voando, seus olhos enviam informações visuais por meio de nervos ao cérebro, o cérebro computa a posição apropriada para o rifle, e seus braços ajustam a posição do rifle, “predizendo” a trilha de voo do pato. Isso, como vimos na aula anterior, também foi a base para o desenvolvimento de sistemas de defesa antiaéreos durante a Segunda Guerra Mundial: a balística e a predição estiveram no cerne da produção de equipamentos pela Sperry Corporation.

Devemos, agora, ver o outro lado da guerra: aquele que foi se desenvolvendo em universidades durante esse período. Uma figura acadêmica foi central nesse contexto. Inclusive, é tida como o “pai da Cibernética”: estamos falando do matemático estadunidense Norbert Wiener, que publicou três livros sobre o tema: Cybernetics: or control and communication in the animal and the machine (1948), The human use of human beings (1950), e God & Golem, Inc.: a comment on certain points where cybernetics impinges on religion (1964).

Em fevereiro de 1940 (cinco meses após os nazistas invadirem a Polônia), Norbert Wiener passou a integrar um subcomitê no NDRC. No dia 22 de novembro do mesmo ano, submeteu ao comitê chefiado por Vannevar Bush um memorando de quatro páginas sobre a predição antiaérea: antes do Natal, seu projeto foi aprovado com financiamento. Wiener contratou, então, como engenheiro chefe de projeto, o graduado no MIT de 27 anos Julian Bigelow, que construiu um aparato no laboratório que simulava as curvas randômicas dos pilotos alemães sobre Londres durante os bombardeios. Após dois anos de pesquisa sem resultados práticos, em 1942, a diretoria do NDRC começou a ficar cética com relação ao trabalho de Wiener e, no mesmo ano, o contrato de Wiener de $2.325 dólares foi terminado sem resultados. Fato que Norbert Wiener jamais aceitou e fez questão de mencionar em seus livros publicados.

Porém, Wiener continuou seus estudos, certo de que a pesquisa sobre o controle da informação entre homens e máquinas traria benefícios ao conhecimento. No inverno de 1947, organizou um seminário interdisciplinar sobre comunicação em forma de jantares com vários cientistas (o sonho de todos nós, convenhamos). Três ideias permeavam o enfoque proposto por Wiener sobre automação e interação homem-máquina, a qual denominou Cibernética (a palavra deriva do termo grego kubernetes, ou seja, piloto, timoneiro dos navios; aquele que regula a todo instante o percurso no mar – porém, Wiener afirma em um de seus livros que só depois veio a saber que “cibernética” já havia sido usada por Ampère com referência à ciência política, no século XIX)

1) controle – o propósito principal dos seres vivos e das máquinas é controlar seus ambientes (ao invés de só observá-los), ou seja, a entropia tem papel fundamental (ela é a medida da desordem, da incerteza, degradação, e perda de informação: reverter isso requer controle por parte de um sistema sobre o ambiente);

2) feedback – a habilidade de qualquer mecanismo usar sensores para receber informação sobre sua performance atual (input) ao invés da performance esperada (quando um feedback tende a se opor a o que um sistema está já fazendo – por exemplo, fazendo um motor parar de girar a torreta ou dizendo a um termostato para desligar um aquecedor, ele é denominado ‘feedback negativo’, e geralmente serve para estabilizar um estado desejado. Para Wiener, o feedback é a propriedade de ser capaz de ajustar conduta futura por meio da performance passada);

3) relação entre homens e máquinas – o feedback promovia um sentido cinestésico para as máquinas, semelhante à consciência humana de posição ou movimento de braços e pernas (Wiener tendia a antropomorfizar as máquinas e, também, a mecanizar o homem ao usar comparações com as máquinas para entender a fisiologia humana).

Vamos aprofundar um pouco cada ponto cibernético.

- Ponto Um – Controle

É impossível falar sobre cibernética sem mencionar a entropia, uma vez que ela é o cerne da própria cibernética. Tudo tende a se perder, a se desorganizar: é o exemplo clássico da nossa querida termodinâmica, onde um corpo mais quente perderá calor para um mais frio. A entropia, assim, é a medida da desordem: quanto mais desorganizado algo estiver, maior será a sua entropia. Pense naquele seu artigo que você tem um prazo apertado e um monte de assuntos para escrever nele: no começo, tudo está uma bagunça – você tem um monte de textos xerocados espalhados pelo quarto, anotações com sua própria letra que não consegue entender, copos de café sujos largados ao lado do teclado, lenços com lágrimas de frustração ao chão… se não fizer nada a respeito, tudo tende a piorar e a bagunça, a aumentar. Mas chega uma hora em que toma vergonha na cara (geralmente devido a uma força maior denominada “desespero”), e começa a organizar tudo, incluindo seus pensamentos, para dar forma ao produto final: um artigo. Assim sendo, você conteve a entropia (por um tempo, ao menos) e gerou informações a partir da organização dela (afinal, as ideias jogadas no artigo não passam disso: informações). Parabéns, seu artigo está pronto para ser esculachado pelos pareceristas!

Artigos à parte, o controle da entropia, como dito, é a base da cibernética. Todos os sistemas cibernéticos vão trabalhar de modo a conter a desordem e, assim, dar um sentido/ação às coisas. Acredito que os seguintes vídeos possam ajudar a esclarecer essas ideias:

- Ponto Dois – Feedback

<Acréscimo versão 2019>

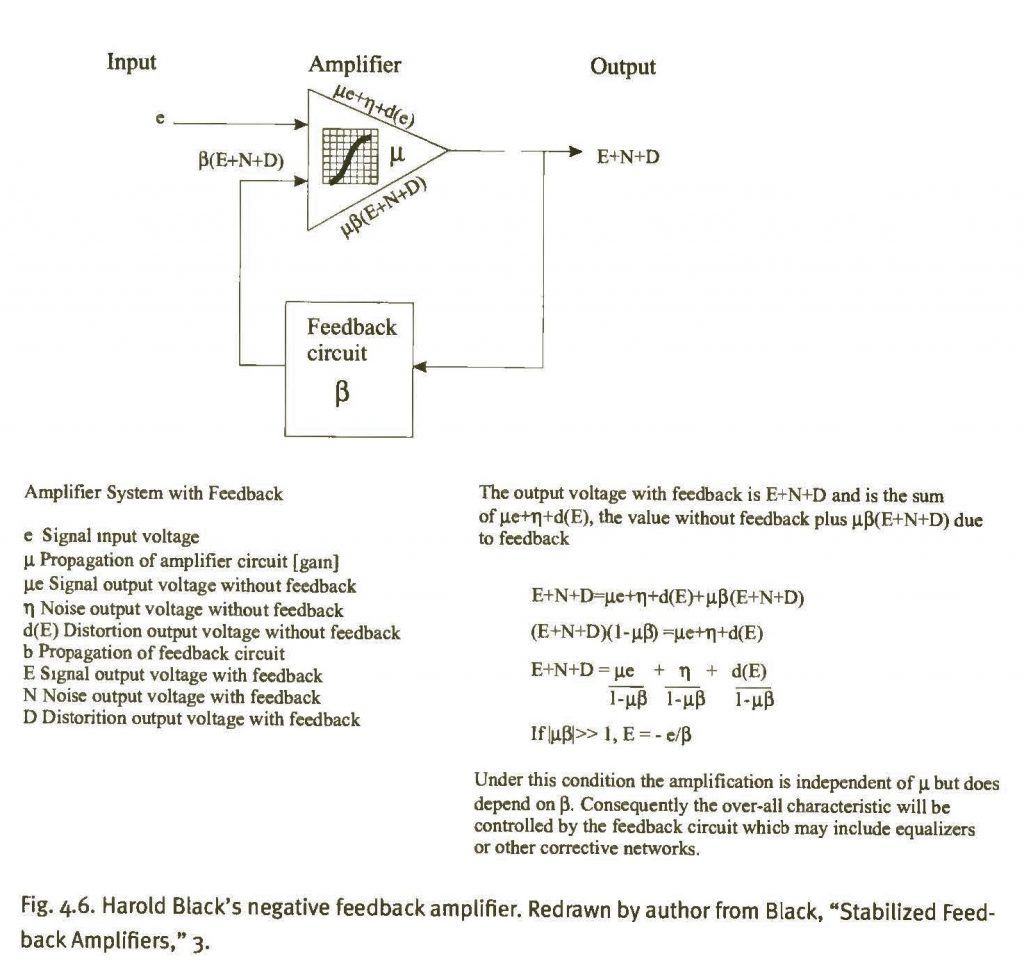

Existe um mito sobre a criação do conceito de feedback. Ele é atribuído a uma epifania do engenheiro da Bell Labs Harold Black que, na travessia de balsa pelo rio Hudson entre Nova Jersey e Manhatan em 1927, encarou a Estátua da Liberdade e percebeu que, se alimentasse a saída (output) de um amplificador de volta à entrada (input), mas em fase reversa, e mantivesse o dispositivo sem oscilar, conseguiria cancelar a distorção na saída. Sete anos depois, Black publicou seu trabalho sobre amplificadores, modificando o entendimento que tínhamos sobre controle de informações até então. Vamos chegar a isso em breve.

As linhas telefônicas estadunidenses do início do século XX possuíam algumas limitações técnicas. Talvez a mais impactante fosse a qualidade do sinal devido à distância entre os pontos de emissão e recepção. Os microfones de carbono permitiam que os fracos sinais acústicos viajassem ao lango dos cabos sem quaisquer tipos de ganho de sinais de ondas sonoras ao longo deles. A resistência inerente dos cabos aos sinais, causando perda de qualidade, ficou conhecida como atenuação. Uma das maneiras de resolver esse problema seria aumentar a espessura dos cabos de cobre, contudo, isso demandaria altos custos devido à reestruturação de toda a rede telefônica, principalmente no preço das ligações entre longas distâncias. Ou seja, se atualmente reclamamos quando nossos sinais de celular ou telefone ficam “pulando” ao utilizá-los, imagine como era ter de se esgoelar ao telefone e torcer para ouvir e ser ouvido no início da telefonia!

Surgia assim a necessidade de se repetir o sinal de voz ao longo das distâncias dos cabos. Esse problema foi atacado pelos engenheiros da AT&T (American Telephone and Telegraph Company), empresa fundada por Alexander Graham Bell em 1885 (que atualmente empresta seu nome ao estádio de futebol americano do meu Dallas Cowboys), na década de 1910. O desenvolvimento de repetidores, para além da famosa conversa transcontinental entre Graham Bell e Thomas Edison em 1915, fez com que houvesse uma profunda mudança conceitual: a rede agora se tornava uma máquina. As linhas telefônicas deixaram de ser meros receptáculos de energia elétrica e passaram a carregar informações. Um repetidor era um amplificador que adicionava energia e renovava o sinal em qualquer ponto da rede cabeada fazendo com que, doravante, as vozes se tornassem sinais que pudessem ser especificados e padronizados. Aqui vai uma curiosidade: a necessidade por criar medidas padronizadas fez com que a atenuação, antes denominada bell pelos engenheiros da empresa de Graham Bell, ganhasse o novo nome de decibel, ou seja, a medida bell fatorada por dez. Esses repetidores “revolucionaram” as telecomunicações (e a Cibernética como um todo) pois permitiram que a mensagem não fosse mais, ela mesma, o seu meio: se antes os sinais sonoros eram apenas atrelados à eletricidade que percorria os cabos, agora esses sinais podiam ser entendidos e manipulados em seus próprios termos, dissociados do meio físico ao qual estavam corporificados.

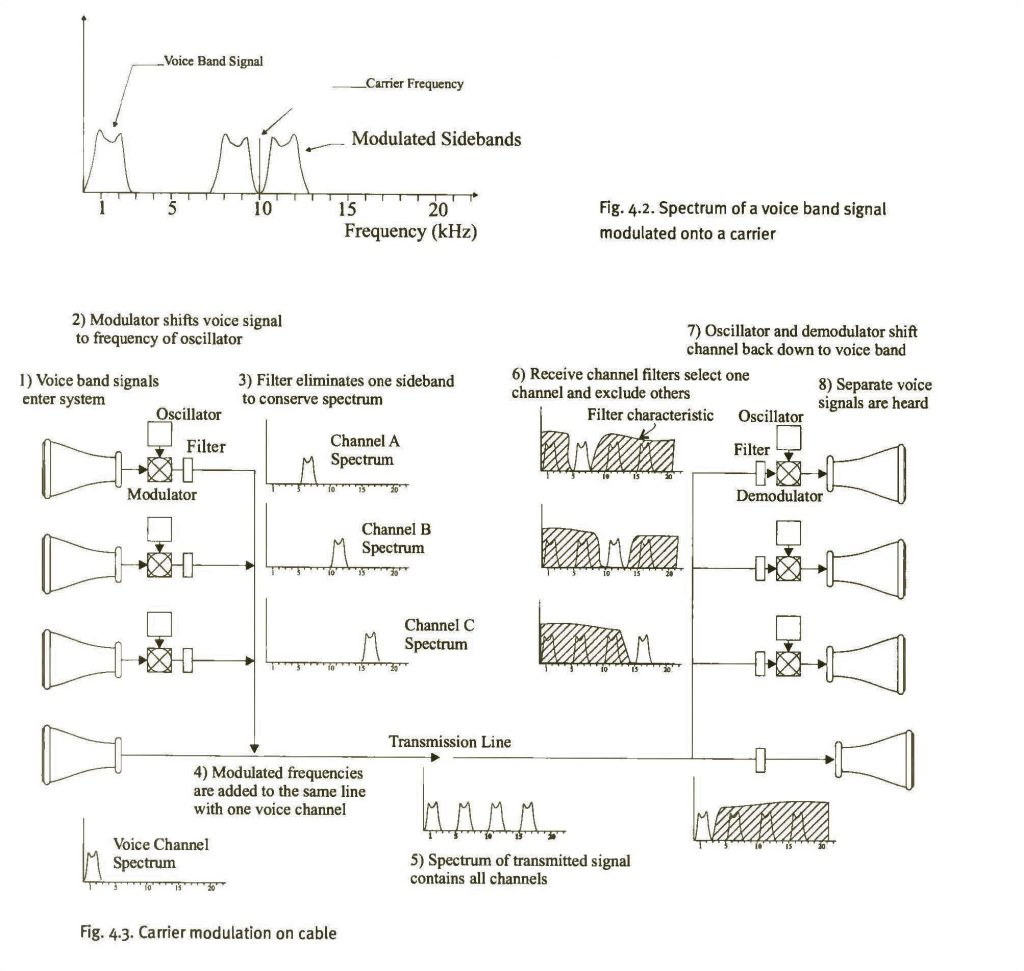

Agora, rapidamente, vamos tentar entender a imagem abaixo.

In: David A. Mindell, Between human and machine. Feedback, control, and computing before Cybernetics, p. 115.

O princípio de funcionamento das telefonia era o seguinte: 1) A pessoa X falava no transmissor de seu telefone, composto por uma peça acústica na qual ficava um microfone de carbono dentro; 2) A fala (tal como no telégrafo) passavam por um oscilador que gerava as ondas sonoras; 3) Essas ondas passavam por um filtro que permitia apenas que uma parte determinada da onda permanecesse (modulação); 4) Essas frequências ondulares de diferentes telefones percorriam o mesmo cabo telefônico; 5) Ao chegar ao receptor, os filtros faziam com que apenas a onda sonora desejava fosse retida, eliminando as demais; 8) O receptor (pessoa Y) ouvia o sinal sonoro.

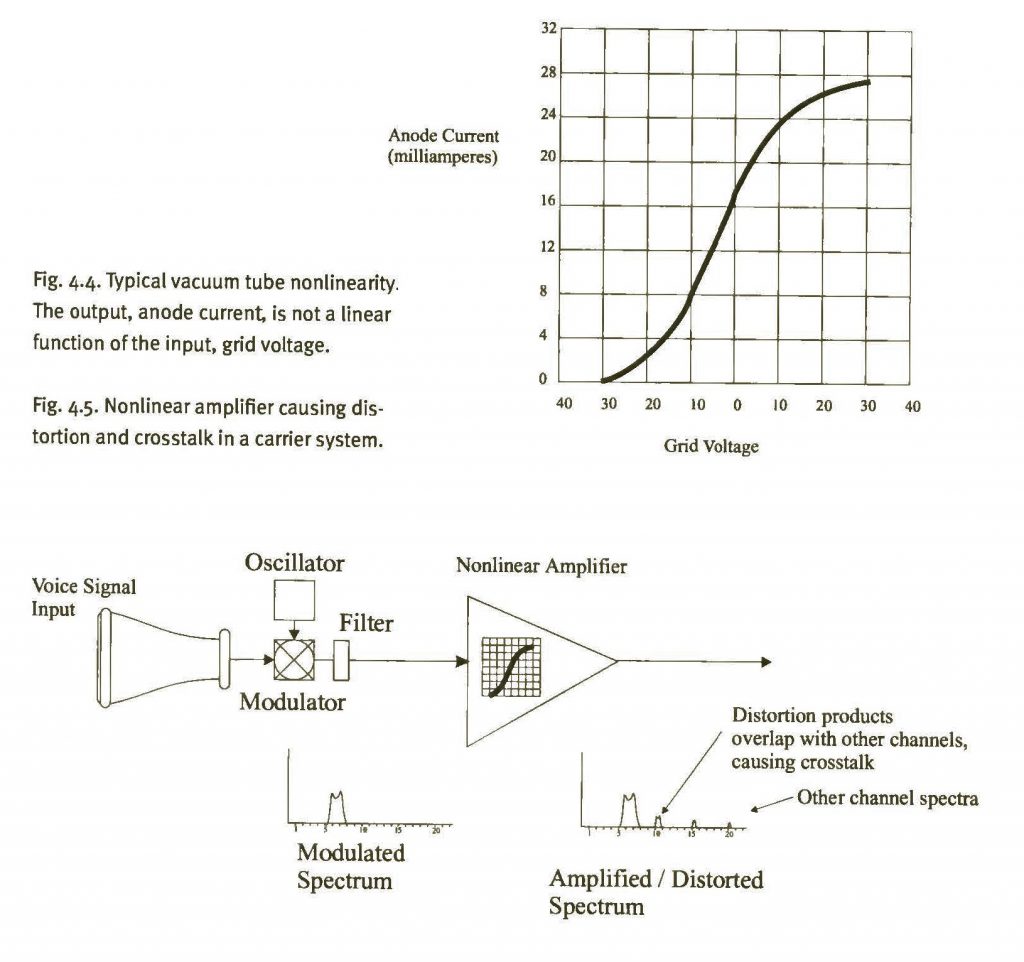

Esse processo de viagem sonora através dos cabos, contudo, como dito, sofria quando a distância era longa: o sinal ia sendo atenuado devido à resistência física do cobre dos cabos. Os repetidores implantados ao longo dos cabos simplesmente, digamos, repetiam o processo descrito… Os repetidores amplificavam o ganho (gain) dos sinais e, com isso, acabavam causando interferências nas ondas, gerando as famosas “conversas cruzadas” (se, assim como eu, você for jovem há mais tempo, certamente experimentou conversas cruzadas ao falar nos quase extintos telefones públicos).

Amplificador não linear. In: David A. Mindell, Between human and machine. Feedback, control, and computing before Cybernetics, p. 117.

Esse problema de amplificação de sinal com ganho na onda foi o que causou a epifania de Harold Black em 1927. Em seu artigo de 1934, após sete anos atacando o problema nos laboratórios Bell, Black pormenorizou a solução encontrada: estabelecendo-se um circuito na saída do amplificador (após o ganho de sinal) que realimentasse a entrada, faria com que a distorção nas ondas sonoras diminuísse – segundo Black, o seu circuito de feedback fez com que a distorção fosse reduzida por um fator de 100.000 (fazendo com que o ganho também fosse reduzido nessa proporção). A demora na publicação dos resultados foi devida à resistência interna de seus pares dentro do ambiente de trabalho. Foi muito difícil convencer seus colegas (e seu chefe de laboratório) de que o feedback, ao contrário do que se utilizava até então, era negativo, não positivo: ou seja, ao invés de o feedback acrescentar ganhos ao sistema, ele os subtraía (os sinais eram revertidos). Até então, acreditava-se que os feedbacks eram todos positivos, causando regenerações ao sistema (o amplificador recebia as ondas de sinais de volta muitas vezes). Harold Black, assim, foi o responsável por mostrar que o seu feedback negativo era o oposto da regeneração: o ganho era reduzido, não aumentado. Essa retroalimentação levava o sistema à estabilidade, sem distorções. A concepção de Black é utilizada até hoje.

Feedback negativo de Black. In: David A. Mindell, Between human and machine. Feedback, control, and computing before Cybernetics, p. 117.

Sugiro, de verdade, que veja esse vídeo:

</Acréscimo versão 2019>

O feedback está relacionado com a entropia pois, ele mesmo, é o controle da entropia! Felizmente, é um conceito mais fácil de se entender. O seu corpo, com todo o respeito, é uma máquina! Mas de feedback. Se a sua saúde estiver em dia, nenhum sintoma aparecerá em seu corpo, correto? Seus órgãos estão trabalhando direitinho e todo o álcool consumido no fim de semana está sendo eliminado normalmente: em outras palavras, todos os órgãos estão dizendo “OK! Estamos OK!” e, assim, a resposta deles, ou seja, o feedback, diz que tudo está em ordem. Contudo, se você tiver, por exemplo, uma infecção no corpo, seu corpo irá lhe avisar de que algo está muito errado aumentando a temperatura, causando a febre. Para controlar sua temperatura, terá de ingerir medicamentos (ou homeopatia, se quiser continuar doente, claro) que farão os sintomas desaparecerem ao controlarem aquilo que está errado dentro de si: quando a febre sumir, você terá o feedback de que tudo está normal novamente (e não será dessa vez que morrerá e ficará livre dos boletos). Resumindo: o seu corpo tem uma norma de conduta que, ao ser modificada (ie. infecção), gera um feedback (febre) avisando que algo deve ser feito a respeito.

Vamos pensar, agora, em questões computacionais divertidas, ou seja, videogames. Você acabou de comprar aquele jogo que tanto queria e colocou a mídia no aparelho e ligou tudo. O jogo começa, você pega o controle e… nada acontece! Isso não é o normal, não é mesmo? O correto seria você interagir, atuando dentro do jogo, movimentando o seu personagem/avatar. O jogo continua parado, e percebe, então, que está sem pilhas novas no controle. Ao substituí-las, o sistema volta a atuar como pretendido: seus movimentos nas alavancas e botões geram movimentos do personagem na tela do jogo. Você está fornecendo inputs (entradas) a partir dos botões do controle que, ao chegarem no videogame, são processados pelo computador e, depois, têm os outputs (respostas/saídas) transmitidos para a tela da TV/monitor onde você vê seu personagem respondendo a cada comando feito no controle em tempo real. Embora tudo seja quase instantâneo, não deixa de ser um loop (laço) de feedback, como pode ser visto abaixo:

- Ponto Três – Relação entre Homens e Máquinas

Esse ponto não tem todas as conceituações dos pontos anteriores, mas não deixa de ser tão fascinante quanto. Um exemplo desse ponto é dado por Wiener quando fala sobre próteses artificiais em seu livro de 1964, denominado God & Golem, Inc.: a comment on certain points where cybernetics impinges on religion: segundo ele, uma perna de madeira é um substituto mecânico para uma parte de carne e sangue, assim, um homem com uma perna de madeira é um sistema composto de partes humanas e mecânicas. O funcionamento cibernético de uma prótese pode ser explicado da seguinte maneira: suponha que um homem teve a mão cortada próxima ao pulso, mas o coto ainda possui músculos que possam ser contraídos – embora esses músculos não possam mais movimentar sua mão e dedos, eles são capazes de produzir sinais elétricos; eletrodos podem captar esses sinais, amplifica-los, e manda-los para motores elétricos em uma mão artificial; contudo, falta ainda, nesse caso, o laço de feedback: a mão artificial não consegue sentir, não consegue tocar, porém, sinais podem ser enviados do membro artificial ao cérebro do amputado por meio de sensores de pressão colocados nos dedos, por exemplo; com o tempo, o amputado aprenderia a substituir a sensação táctil natural de outrora pela fornecida através dos sensores.

Esse vídeo é bem interessante:

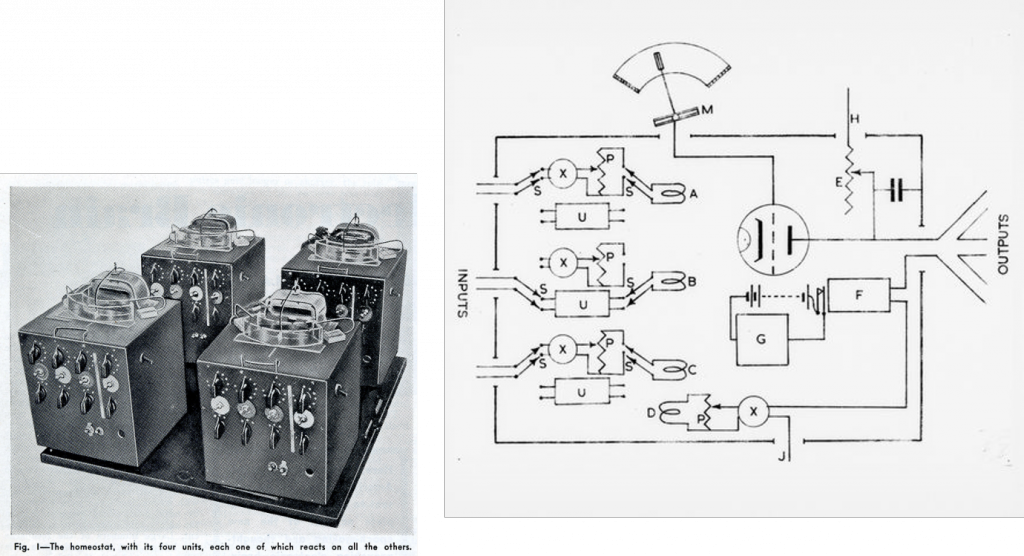

Outro tema fundamental na Cibernética é o da homeostase, ou seja, a capacidade de adaptação de um sistema para que ele se mantenha sempre em equilíbrio. Um pesquisador britânico foi o responsável por demonstrar, na prática, essa conceituação. Em 1948, a primeira “maquina pensante” foi inventada na Inglaterra, no hospital de saúde mental em Barnwood, uma vila perto de Gloucester. O médico Ross Ashby inventou o homeostato, uma máquina inspirada por seu trabalho junto aos pacientes com distúrbios mentais.

Ashby levou 15 anos para fazer o design de seu cérebro eletrônico e mais 2 anos para construí-lo: ao todo, custou £50. Sobre a estrutura e funcionamento do homeostato: tinha quatro interruptores de controle de bombas RAF na base, com quatro caixas de alumínio. As únicas partes móveis eram quatro pequenos imãs, balançando como agulhas em compassos no topo de cada caixa de alumínio. Cada uma das quatro caixas tinha quinze interruptores brutos para mudar vários parâmetros. Embora, à primeira vista, as caixas parecessem desconectadas umas das outras, elas interagiam entre si. Quando a máquina era ligada, os imãs em uma unidade podiam ser movidos pelas correntes elétricas das outras unidades. As movimentações dos imãs, por sua vez, alteravam as correntes, que mudavam as movimentações novamente, e assim por diante. A máquina foi elaborada de modo a manter os quatro imãs eletromagnéticos em uma posição estável, com a agulha sobre cada caixa centralizada no marcador: essa posição era a “normal/confortável” do homeostato. O experimento, contudo, servia para criar “desconforto” na máquina e ver como ela se comportava. Isso podia ser alcançado revertendo a polaridade de uma conexão, mudando algum feedback da máquina, revertendo um imã, restringindo o movimento de um imã em um lado, juntando imãs… A ideia era causar distúrbio no equilíbrio da máquina e ver como ela reagia. Não importava o que Ashby fizesse, logo a máquina encontrava um meio de se adaptar às novas condições, recentrando as agulhas. Ashby acreditava que o homestato resistia a qualquer tentativa de distúrbio.

<Acréscimo versão 2019>

Tomando por base o livro The Cybernetic Brain. Sketches of another future (2010), de Andrew Pickering, vamos tentar entender melhor o diagrama de funcionamento de uma unidade do homeostato ilustrado abaixo presente na obra Design for a Brain, de Ashby, publicada em 1952.

Cada unidade tinha entradas (inputs) independentes umas das outras que eram alimentadas em um conjunto de bobinas (A, B, C, D), gerando, assim, um campo magnético que fazia um imã em forma de barra (M) se movimentar em seu eixo vertical. Ao imã estava anexado uma palheta de metal protegida por um invólucro de acrílico (o topo em cada homeostato; o desenho em forma de arco na parte de cima do diagrama) que captava a voltagem dependendo de sua posição: essa voltagem controlava o tríodo (válvula eletrônica; o círculo sem nome no diagrama) que, por sua vez, controlava as correntes elétricas da saída (output). Cada unidade podia operar de dois modos, de acordo com os interruptores posicionados na frente do dispositivo (letra S, no diagrama): no primeiro modo de configuração, a corrente de entrada (input) chegava à bobina magnética através de um comutador (X), que invertia a polaridade da entrada, e também através de um potenciômetro (P), que aumentava ou diminuía a corrente elétrica de acordo com sua configuração – as configurações do P e do X eram estabelecidas manualmente, usando os botões das fileiras superiores e intermediárias presentes na frente da unidade; no segundo modo, o interruptor S fazia com que a corrente de entrada (input) passasse por um uniseletor/interruptor de passo (letra U, no diagrama) que contava com 25 posições e, ao contrário dos potenciômetros e comutadores, não tinha sua configuração estabelecida manualmente: eram controlados por um comportamento interno do homeostato – quando a corrente elétrica de uma unidade ficava acima do limite pré-estabelecido, o relê (F) fechava, fazendo com que a bobina (G) levasse o uniseletor à próxima posição, de forma randômica.

Ainda seguindo a análise de Pickering, o autor cria uma situação hipotética para ilustrar o funcionamento do homeostato (pp. 104-105). Primeiramente, é necessário frisar que qualquer unidade do homeostato é inerte, não faz nada sozinha. Dito isso, vamos supor que para uma das unidades (podemos chamá-la de homeostato 1) coloquemos o interruptor (S) para se conectar ao uniseletor (U) enquanto os demais homeostatos permanecem com o interruptor configurados manualmente por meio dos comutadores e potenciômetros: em outras palavras, o homeostato 1 tem propriedades variantes enquanto os demais têm propriedades fixas. Quando essa combinação é acionada, o homeostato 1 pode se encontrar em uma das duas condições: 1) condição de equilíbrio estável – significando que a palheta de metal no invólucro de acrílico permanecerá na posição central, demonstrando que não há saída de corrente elétrica; 2) condição instável – significando que a palheta de metal pode atingir os níveis máximos de medição: nesse caso, quando a corrente elétrica cruzasse o limite estabelecido, o relê fecharia, fazendo com que o uniseletor mudasse de posição, obrigando o homeostato 1 a, novamente, buscar uma das duas condições até que, em determinado momento, permanecesse na condição estável e, assim, a palheta de metal repousasse na posição central.

Desse modo, iniciado em qualquer configuração, o homeostato podia reorganizar-se randomicamente até encontrar uma condição de equilíbrio dinâmico com o seu ambiente, sem qualquer intervenção externa.

<Acréscimo versão 2019>

Em 1952, Ashby foi convidado a apresentar o homeostato na Macy Conference em Nova Iorque: na ocasião, estavam presentes Gregory Bateson, Margaret Mead, Warren McCulloch, Julian Bigelow e Arturo Rosenblueth (Norbert Wiener não estava na conferência). Indo na contramão da maioria dos ciberneticistas presentes, Ashby acreditava que não havia distinção entre sistema e ambiente: o homeostato era o organismo e o ambiente ao mesmo tempo, os imãs elétricos eram um distúrbio e um meio de superar o ambiente (isso deixou Bigelow bastante nervoso e gerou discussões). Para Ashby, sua máquina aprendia pois se adaptava a cada situação que se apresentava, tal como se treinam os cães (o comportamento muda de acordo com o aprendizado). Com seu aparelho, Ross Ashby reforçou as ideias em voga de que: 1) os humanos são mecanismos que respondem a seus ambientes tentando manter a homeostase; 2) a restrição para se criar máquinas inteligentes reside em formular os problemas de modo correto; e 3) um conceito de informação que privilegia a exatidão sobre o significado serve melhor a um modelo de construção do que um conceito de informação impreciso. Para Ashby, a cibernética não era sobre matemática, era sobre comportamento, sendo essencialmente funcional e behaviorista.

Se você tiver tido uma formação prévia em Arqueologia, tenho certeza de que chegou até esse ponto pensando: ” Mmmm… Parece que já vi algumas coisas assim…”. Com toda razão! A Cibernética não ficou restrita ao mundo das Exatas (e Biológicas): ela também influenciou demais as Humanidades, principalmente as Ciências Sociais, nas décadas de 1950 e 1960. A Teoria Geral de Sistemas (T.G.S.) elaborada pelo biólogo austríaco Ludwig von Bertalanffy em meados do século XX teve impacto na cibernética e, consequentemente, nas áreas impactadas pela cibernética (dentre elas, a Arqueologia). Resumidamente, para Bertalanffy, um sistema é um conjunto de partes interagentes e interdependentes que, juntas, formam um todo unitário com determinado objetivo e efetuam determinada função em um ambiente. Ou seja: um sistema é formado por elementos independentes que interagem entre si a fim de manter o equilíbrio geral, ou seja, a homeostase. Isso é bastante semelhante ao que foi proposto pela corrente arqueológica do Processualismo, correto?

O artigo de Lewis Binford “Archaeology as Anthropology” (1962) é tido como a pedra angular do Processualismo. Em seu texto, Binford identifica três campos de comportamento que podem ser inferidos a partir dos artefatos e dos contextos em que foram encontrados: ambiental, social e ideológico. Pode-se dizer que o Processualismo (também chamado de Nova Arqueologia) enfatiza a importância de se dar explicação a partir do confronto de hipóteses. Ao contrário do Histórico-Culturalismo, ou arqueologia tradicional, em que semelhanças e diferenças eram explicadas por pessoas compartilhando normas sobre a cultura, a arqueologia processual explica a variação em termos de participação diferencial na cultura (entendida como nosso principal meio de adaptação). O objetivo da arqueologia processual é buscar as razões de por quê ocorrer a variação adaptativa. Para tanto, o processualismo procura leis gerais no comportamento e nos fenômenos da vida social (proximidade com a Antropologia); os padrões comuns podem ser inferidos a partir dos artefatos, que, por sua vez, são classificados de acordo com suas funções, podendo ser tecnômicos (tecnologia, ambiente); sociotécnicos (organização social); ou ideotécnicos (idéias, valores, crenças). Outra característica importante dessa corrente é a teoria de médio alcance, baseada no experimento e na observação de pessoas e animais fazendo coisas no mundo moderno que podem nos auxiliar a entender como padrões são criados. Também faz parte dessa teoria a utilização da Arqueologia Experimental (fabricação de artefatos no presente) para a compreensão da tecnologia do passado. O objetivo da teoria de Binford é compreender transformações evolutivas. O foco central do processualismo não é chegar aos indivíduos, mas ao sistema que há entre o indivíduo e o artefato. O indivíduo é impotente para mudar o sistema (natural ou social). A mudança cultural não ocorre por meio da difusão ou da migração (como dita o Histórico-Culturalismo), mas em termos de processo, sendo os dados arqueológicos particularmente úteis ao estudo das mudanças ocorridas na longa duração.

Diagrama de Sistema Sociocultural. In: David L. Clarke, Analytical Archaeology, 1968.

Se tudo ficou (mais ou menos) claro até aqui, você deve ter percebido que essa área de pesquisa sobre comunicação e controle denominada Cibernética lida com conceituações da física e da biologia para formular uma proposta sobre o que é a informação, e como ela se difunde (por sistemas, nesse caso). Norbert Wiener foi o grande expoente da Cibernética nas décadas de 1940 e 1950, e ainda vamos conversar sobre ele neste curso.

Leitura recomendada

Dessa vez não vou recomendar excertos, pois os temas são bem complexos e caberá a você olhar tudo e selecionar aquilo que lhe interessa. Se, dentre todos, eu puder sugerir uma leitura completa, fique com Cibernética e sociedade: o uso humano de seres humanos, do Norbert Wiener (é o livro escrito para aqueles que, como eu, são das Humanidades).

› WIENER, Norbert. Cybernetics: or control and communication in the animal and the machine. Cambridge, Massachusetts: The MIT Press, 2nd ed., 1985.

› WIENER, Norbert. Cibernética e sociedade: o uso humano de seres humanos. Tradução: José Paulo Paes. São Paulo: Cultrix, 1968.

› WIENER, Norbert. God & Golem, Inc.: a comment on certain points where cybernetics impinges on religion. Cambridge, Massachusetts: The MIT Press, 1964.

› ASHBY, W. Ross. An introduction to Cybernetics. London: Chapman & Hall LTD, 1957.

› ASHBY, W. Ross. Design for a Brain. The origin of adaptative behaviour. London: Chapman & Hall LTD, 1960.

› BINFORD, Lewis. “Archaeology as Anthropology”. In: American Antiquity, vol. 28, n. 2, 1962, pp. 217-225.

› BERTALANFFY, Ludwig von. Teoria geral dos sistemas. Fundamentos, desenvolvimento e aplicações. Tradução: Francisco M. Guimarães. Petrópolis: Editora Vozes, 2010.

› SONI, Jimmy & GOODMAN, Rob. A mind at play: how Claude Shannon invented the Information Age. New York: Simon & Schuster, 2017.

(OK, esse é excerto. Faz parte de uma excelente biografia de Claude Shannon. É um capítulo sobre a base da Informação!)

› PICKERING, Andrew. The cybernetic brain: sketches of another future. Chicago: University of Chicago Press, 2011.

(Mais um excerto – que poderia ser um livro… O capítulo de Pickering sobre Ashby é muito informativo!)

Jogo recomendado

Existem vários exemplos de jogos que lidam com controle de sistemas para adaptação. CivCity: Rome (2006) é um deles e você pode gastar várias horas administrando uma cidade romana.

Filme recomendado

Essa palestra de um dos maiores ciberneticistas, Stafford Beer, é bem elucidativa. Infelizmente, não possui legendas.

Aula 3 (Teoria) – “Domo arigato, Mr. Roboto” – máquinas feitas à imagem dos homens

Antes de prosseguirmos, uma música para relaxar:

Chegamos à era da automação. Ela foi liderada pela Cibernética, e muitos pesquisadores pioneiros estiveram envolvidos na construção de máquinas automatizadas/autônomas.

Os robôs como os conhecemos surgiram na década de 1940/1950, mas a ideia de uma máquina autônoma era bem anterior, sendo que o uso da palavra “robô” remonta à década de 1920, na antiga Tchecoslováquia. A origem da palavra robô (robot) vem da peça de teatro do autor tcheco Karel Tchápek denominada R.U.R, abreviação de Rossumovi univerzální roboti (Robôs Universais de Rossum). A peça, de 1920, conta a história de uma fábrica que faz trabalhadores artificiais denominados roboti (uma junção das palavras tchecas robota – que significa “trabalho obrigatório” – e robotnik – que significa “servo”): eles se revoltam contra seus criadores e terminam destruindo a humanidade. Os robôs na peça não são simples amontoados de metal – são feitos de matéria orgânica e de aço.

Para quem tiver interesse na peça de teatro, achei no YouTube uma versão italiana com legendas em inglês muito legal:

O que é, afinal, um robô?

Vou utilizar aqui a definição da roboticista sérvia Maja Matarić em seu livro Introdução à robótica (São Paulo: Editora Unesp/Blucher, 2014): “Um robô é um sistema autônomo que existe no mundo físico, pode sentir o seu ambiente e pode agir sobre ele para alcançar alguns objetivos” (p. 19). A autora, didaticamente, desmembra essa definição para pormenorizar as conceituações (pp. 19-21).

- Um robô é um sistema autônomo porque “atua com base em suas próprias decisões e não é controlado por um ser humano” (se o fosse, seria teleoperado);

- Um robô é um sistema autônomo que existe no mundo físico porque pertence ao “mesmo mundo no qual existem pessoas, animais, objetos, árvores, o clima e muitas outras coisas” (a robótica lida com as leis da física do mundo; robôs que existem nos computadores são simulações);

- Um robô é um sistema autônomo que existe no mundo físico e pode sentir o seu ambiente porque “tem sensores, ou seja, possui alguns meios de perceber (por exemplo, ouvir, tocar, ver, cheirar) e obter informações do mundo. (…) Um robô verdadeiro pode sentir seu mundo somente por meio de sensores, assim como as pessoas e outros animais o fazem por intermédio dos sentidos”;

- Um robô é um sistema autônomo que existe no mundo físico e pode sentir o seu ambiente e pode agir sobre ele pois “tomar medidas para responder às informações sensoriais e para alcançar o que se deseja é uma condição necessária para ser um robô. Uma máquina que não age (ou seja, não se move, não afeta o mundo, mudando alguma coisa) não é um robô”;

- Um robô é um sistema autônomo que existe no mundo físico e pode sentir o seu ambiente e pode agir sobre ele para alcançar alguns objetivos porque “esperamos que um robô real tenha um ou mais objetivos e se comporte de forma a atingi-los”.

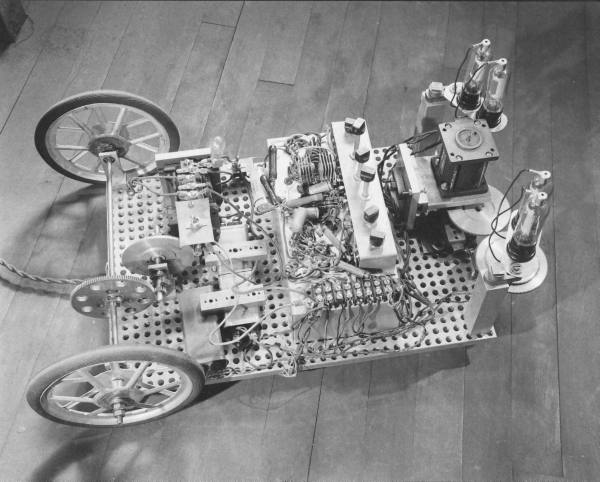

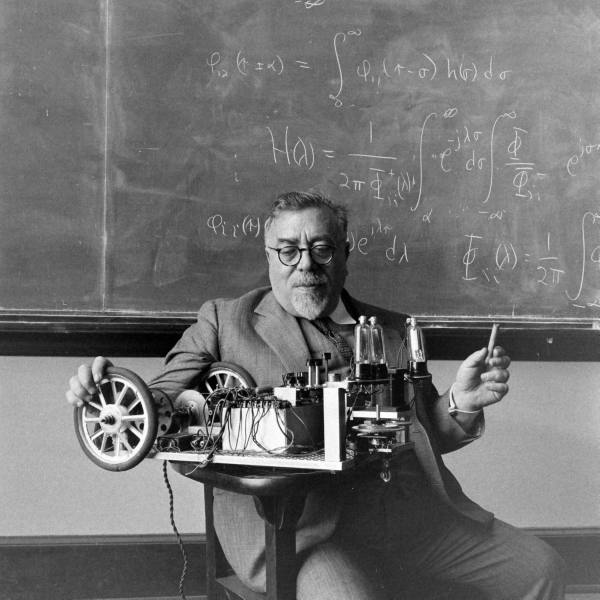

Embora tenha publicado seu livro em 2007, os pontos levantados por Matarić sempre fizeram parte daquilo que se entende por “robô” quando o assunto é cibernética. Em 1949/1950, Norbert Wiener desenvolveu o robô Palomilla: um triciclo com duas rodas grandes atrás e uma pequena na frente montadas em uma base retangular de metal. Nos dois cantos frontais, o robô tinha duas fotocélulas representando olhos: o output das fotocélulas era amplificado e alimentado em uma calha que controlava a pequena roda frontal. Desse modo, Palomilla se movia sempre em direção à luz (ou ao contrário, se a voltagem das fotocélulas fosse revertida). Palomilla foi desenvolvida para simular duas doenças neurais: Parkinson e tremores (lembrando que a cibernética sempre esteve intimamente ligada à biologia, também).

<Acréscimo versão 2019>

É importante ressaltar que, ao contrário da Cibernética estadunidense propagada por Wiener, a versão britânica dos estudos cibernéticos não era focada em aparatos militares, nem realizada com auxílio de grandes verbas: essencialmente, a Cibernética britânica era amadora e centrada no entendimento do cérebro humano como máquina (Pickering, 2010).

Um dos ciberneticistas britânicos mais famosos desse período foi o neurofisiologista Grey Walter (1910-1977). Durante sua trajetória como pesquisador, Walter percorreu três campos principais de problemas: 1) estudo individual dos componentes do cérebro (ou seja, um enfoque reducionista); 2) uso de EEG (eletroencefalograma) para entender as ondas de sinais cerebrais derivadas de estímulos; 3) construção de modelos de cérebros. O terceiro campo foi o que levou Walter à robótica.

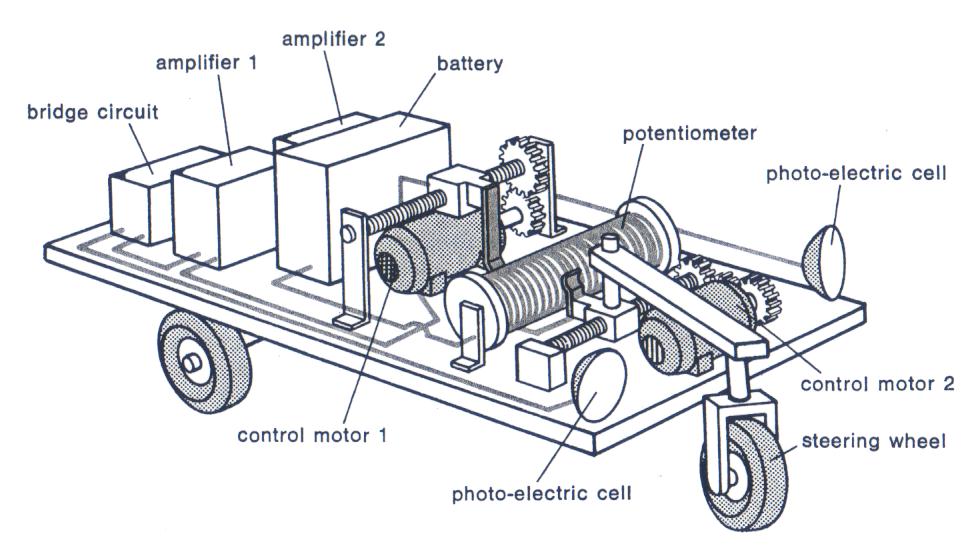

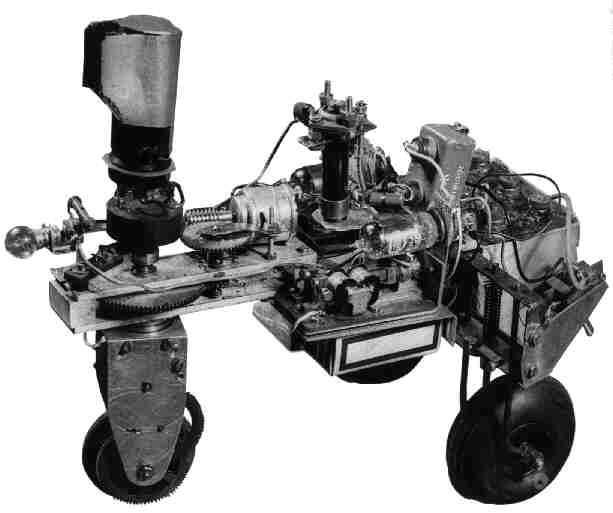

Walter dizia que suas tartarugas robôs pertenciam a uma nova espécie inorgânica, a Machina speculatrix (máquina especuladora, em português). As duas primeiras tartarugas, nomeadas Elsie e Elmer, foram construídas em sua casa nos tempos livres entre a Páscoa de 1948 e o Natal de 1949. As tartarugas possuíam duas rodas traseiras e uma dianteira, que era alimentava por uma bateria a fim de movimentar o conjunto para frente, enquanto outro motor era o responsável por fazer o conjunto da “cabeça” rotacionar em seu eixo: ao ir de encontro a um obstáculo, um interruptor de contato no corpo fazia com que a máquina recuasse e, assim, voltasse a ficar livre. A “cabeça” da tartaruga possuía uma célula fotoelétrica que, ao captar uma fonte de iluminação, cortava a energia do motor de sua rotação, fazendo com que o conjunto caminhasse para a frente, em direção à luz. Quando a fonte de luz cessava, a tartaruga voltava ao seu modo de “busca” normalmente. Quando a bateria começava a ficar fraca (por falta de luz na fotocélula), a tartaruga buscava uma fonte de iluminação para se recarregar sozinha.

Tartaruga sem a carapaça. In: Jakob Fredslund, Simplicity applied in projects involving embodied, autonomous robots, 2002, p.8.

Qual a relação da tartaruga, então, com o objeto de pesquisa dos primeiros ciberneticistas britânicos: o cérebro? Para Grey Walter, a tartaruga era um organismo vivo, com órgãos motores, sensores e, também, cérebro, que, nesse caso, era constituído por um simples circuíto formado por uma válvula eletrônica, um capacitor e um conjunto de relês (que eram acionados ou desligados de acordo com os diferentes comportamentos da tartaruga). Assim, a tartaruga, quando relacionada com a ciência do cérebro, podia ser entendida como uma forma de comportamento adaptável: ao explorar o seu entorno, reage a ele, assim como todos os organismos o fazem – isso sugeria, então, que o cérebro orgânico podia conter estruturas semelhantes à tartaruga. Walter denominou a rotação da fotocélula em 360º buscando luz como escaneamento, e afirmou que o cérebro também possuía essa capacidade, pois constantemente escaneava, utilizando os sensores de entrada do corpo humano, objetos de interesse, padrões no mundo e também configurações inerentes ao ser.

</Acréscimo versão 2019>

Um pouco antes de Wiener, o neurofisiologista britânico William Grey Walter (1910-1977) construiu uma série de máquinas inteligentes conhecidas por “tartarugas”. Duas das mais famosas tartarugas receberam os nomes de Elmer e Elsie, baseados nos acrônimos de ELectro MEchanical Robots (robôs eletromecânicos) e Light Sensitive (sensíveis à luz). Essas tartarugas eram robôs simples, construídos com três rodas em forma de triciclo, usando a roda dianteira para direção e as duas rodas traseiras para condução; também contavam com uma célula fotoelétrica (ie. sensor) para detectar níveis de luminosidade, um sensor de colisão (acionado quando a “carapaça” esbarrava em outros objetos espalhados pelo ambiente), uma bateria recarregável (que lhe garantia autonomia), três motores para movimentação das rodas, e um circuito eletrônico analógico com dois tubos de vácuo (Matarić 2014: pp. 28-29). Com todos esses elementos, os seguintes comportamentos eram esperados das tartarugas: procurar a luz e ir em direção a ela (ou evitá-la), desviar de obstáculos no ambiente, e recarregar a bateria. Podemos ver a simpática invenção de Grey Walter nos vídeos abaixo:

A automação nunca deixou de ser uma questão delicada entre os ciberneticistas e a população em geral. Para Wiener, a automação era o equivalente do trabalho escravo e devia aceitar a condição econômica do trabalho escravo. Também dizia que a automação iria produzir uma situação de desemprego comparável à da Depressão (e, em 1962, o presidente John F. Kennedy foi perguntado por um jornalista sobre o impacto dos computadores e da automação nos empregos; o presidente respondeu que o maior desafio nos anos 60 seria achar emprego para os trabalhadores substituídos pela automação: a resposta era mais baseada em medo do que em fatos…). Norbert Wiener também refletiu sobre os impactos da automação/cibernética na religião e elencou três pontos de conflito entre homens, máquinas e Deus em seu livro God and Golem, Inc.:

1) As máquinas podiam aprender – as máquinas mostravam que a Bíblia podia estar errada, pois as criações conseguiam suplantar os criadores (por exemplo, no jogo de damas ou xadrez): poderes mecânicos, segundo Wiener, mostravam os limites do poder divino;

2) As máquinas podiam se auto reproduzir – havia o tabu de que apenas Deus pode criar vida. As máquinas mostraram que elas eram capazes, de fato, de fazer outras máquinas a sua semelhança;

3) As máquinas podiam trazer à tona magia e lenda – Wiener não via a máquina como mágica: ele via a mágica como mecânica. Para ilustrar a mecânica da mágica, Wiener usou o poema de Goethe de 1797 O Aprendiz de Feiticeiro. Para Wiener, a história seguia um padrão que era refletido em inúmeras fábulas, contos de terror e textos religiosos: o homem ambicioso invoca a ajuda da mágica apenas para descobrir que perdeu o controle sobre sua criação.

Para encerrar o tópico sobre automação/robôs na cibernética, uma curiosidade. Durante os anos 1960, dois termos se tornaram famosos: 1) cybernation – referindo-se à automação computadorizada na indústria; 2) cyberculture – criado pela matemática Alice Mary Hilton em 1963, para dizer que a automação não era simplesmente uma segunda revolução industrial: para ela, a automação traria à humanidade a liberdade de tarefas para poder se tornar livre para pensar (se o cultivo, ou seja, a agricultura, trouxe energia para criar a civilização, a automação, ou seja, a cibercultura, teria efeito parecido, com a vantagem de libertar os humanos da necessidade de cultivar os próprios alimentos).

Leitura recomendada

› WIENER, Norbert. God & Golem, Inc.: a comment on certain points where cybernetics impinges on religion. Cambridge, Massachusetts: The MIT Press, 1964.

Já foi recomendado na aula anterior, mas vale a releitura pelos aspectos do confronte homem/máquina vs Deus.

› ČAPEK, Karel . RUR. 1920.

Se quiser ler a obra que deu origem à palavra “robô’, fique à vontade.

› WALTER, W. Grey. “An imitation of life”. In: Scientific American, 182(5), 1950, pp. 42-45.

Artigo de Grey Walter sobre suas simpáticas “tartarugas”.

› PICKERING, Andrew. The cybernetic brain: sketches of another future. Chicago: University of Chicago Press, 2011.

Capítulo que detalha o trabalho de Grey Walter.

Jogo recomendado

Já sonhou em controlar o seu próprio robô em uma simulação? Com Xemo: Robot Simulation (2016) você pode!

Clique aqui para acessar a página de download gratuito: Acessar.

Filme recomendado

Vejam a série da Netflix Love Death + Robots. É muito, muito boa!

Aula 4 (Teoria) – Talos, Maschinenmensch, Major Motoko Kusanagi, Rick Deckard e Borgs – o desenvolvimento do ciborguismo, ou “homens feitos à imagem das máquinas”

Vamos começar com um dos meus filmes preferidos de todos os tempos: Metrópolis (Metropolis, dir. Fritz Lang, 1927)!

Androides (robôs) e ciborgues acabam por se confundir, às vezes. Nem sempre é clara a divisão entre ambos. Geralmente, é tido que os robôs não possuem propriedades orgânicas (ao contrário dos ciborgues). Aproveitando a aula anterior, vamos utilizar aquela definição de robô neste curso, ou seja, máquinas sem suporte orgânico humano. Isso, não impede, contudo, que os robôs sejam feitos à imagem dos homens! Muitos robôs possuem braços e pernas e, principalmente, são utilizados para substituir-nos em algumas de nossas tarefas, como podemos deduzir no filme Blade Runner (dir. Ridley Scott, 1982):

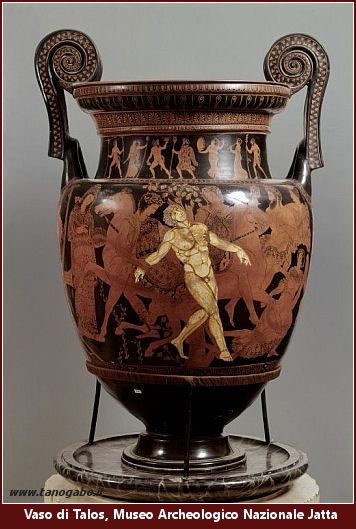

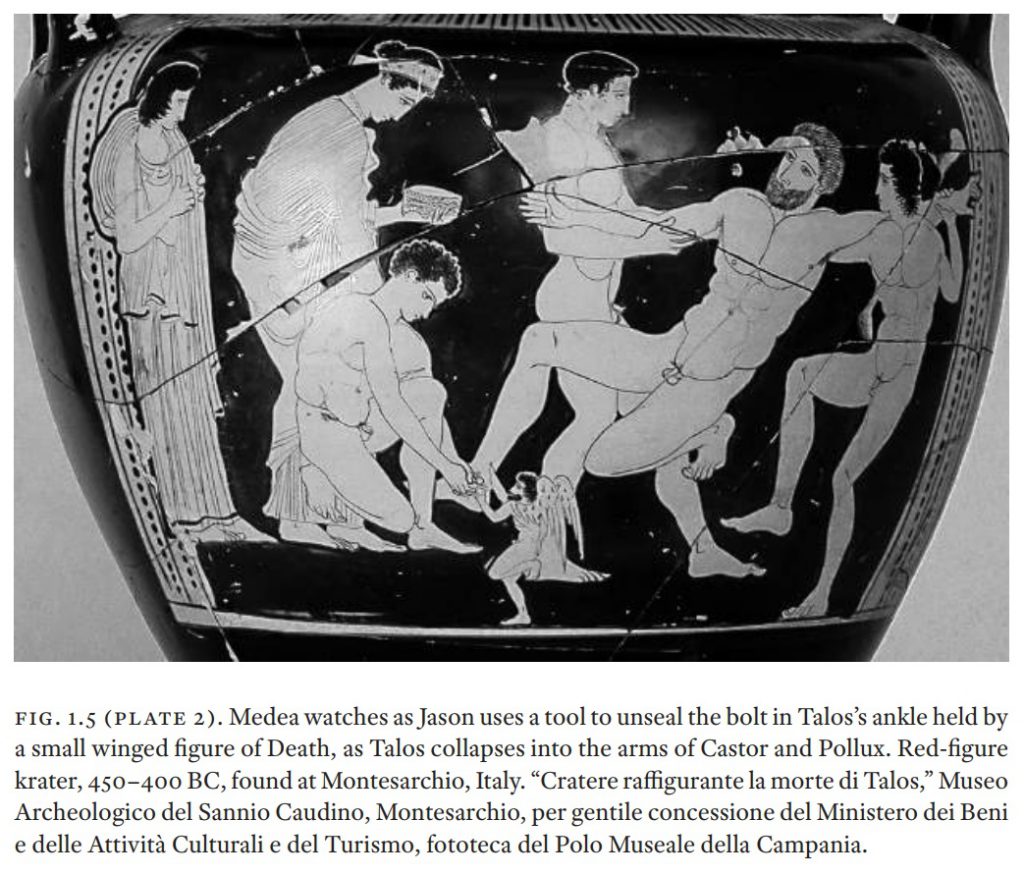

Um dos primeiros autômatos registrados pertence à mitologia grega. Em sua obra Biblioteca, Apolodoro descreve brevemente um autômato de bronze chamado Talos que atuava como guardião em Creta (Livro I, capítulo 9, seção 26):

“Colocando o mar a partir daí, eles [os argonautas de Jasão] foram impedidos de tocar em Creta por Talos. Alguns dizem que ele era um homem da raça de Bronze; outros, que ele foi dado a Minos por Hefesto; ele era um homem de bronze, mas alguns dizem que ele era um touro. Ele tinha uma única veia que se estendia de seu pescoço aos tornozelos, e uma cavilha de bronze ao final da veia. Este Talos manteve a guarda, rondando a ilha três vezes todos os dias; por isso, quando viu o Argo de pé na costa, ele o atacou, como de costume, com pedras. Sua morte foi provocada pelas artimanhas de Medéia, talvez o drogando, ou, como outros dizem, prometendo torná-lo imortal e depois arrancando-lhe a cavilha da veia, de modo que todo o ichor jorrou e ele morreu. Mas alguns dizem que Poias o matou atirando em seu tornozelo”.

Abaixo, um trecho do excelente filme Jasão e o Velo de Ouro (Jason and the Argonauts), de 1963, com animação em stop motion do mestre Ray Harryhausen.

<Acréscimo versão 2019>

A figura de Talos na mitologia grega fornece uma boa discussão sobre o seguinte tópico: ele era um robô ou não? Segundo a historiadora Adrienne Mayor em seu livro Gods and Robots: Myths, Machines, and Ancient Dreams of Technology (2018), Talos ainda gera discussão entre os especialistas. É quase senso comum os robôs serem vistos como seres feitos, não nascidos (made, not born), ou seja, não são naturais pois foram criados por alguém ao invés de terem sido dados à luz por meio de gestação: os deuses do Olimpo, por exemplo, eram nascidos, não feitos (born, not made), aproximando-se, então dos mortais que habitavam a Terra.

Como podemos notar no trecho acima de Apolodoro, Talos foi feito por Hefesto e, por isso, se enquadraria no quesito de autômato puro, pois, como vimos na aula passada sobre Robótica, os robôs precisam se enquadrar nos quesitos de independência (ou seja, movimentar-se livres de cabos e fios) e usam sensores para interagir dentro de um mundo físico. Talos era assim também: ele possuía meios de se locomover sozinho, seus sensores (olhos) viam os inimigos que se aproximavam de Creta e, assim sendo, agia no ambiente para barrar a passagem deles. Talos é um robô, correto?

Mmmm… continuando no texto de Apolodoro, a coisa complica quando chegamos na parte da veia que atravessa todo o seu corpo e está repleta de icor. Os gregos antigos acreditavam que o sangue dos deuses – e também dos mortais – era um fluido que auxiliava na vida, denominado icor. Talos tinha icor em sua veia e, por isso, a estratégia dos argonautas foi a de sangrá-lo até a morte cortando a veia em seu tornozelo. Podemos apontar duas coisas interessantes aqui: 1) o fato de icor correr pela veia de Talos o difere de uma matéria inanimada: ele não é puramente um autômato vazio, é algo mais; 2) o corte realizado na veia na altura do tornozelo de Talos demonstra uma prática que os gregos faziam na Medicina: sangrias (inclusive, sabiam muito bem que, se deixar sangrar demais a veia do tornozelo, a pessoa morreria). É interessante notar que a abertura no tornozelo de Talos seria o equivalente do orifício de respiro de uma peça de bronze produzida por meio da técnica da cera perdida: tal como o bronze escorre por esse duto, o icor de Talos se esvai. Talos, então, é uma peça de bronze no sentido técnico, mas imbuído de vida.

Desse modo, Talos se assemelha aos humanos. E ele também emula os humanos: o modo de Talos enfrentar seus inimigos era abraçá-los e forçá-los contra o seu corpo de bronze que, para se defender, aquecia-se graças ao icor presente dentro dele, queimando os desafetos. Assim, Talos, na mitologia grega, poderia ser visto como uma amálgama entre homem e máquina/autômato/ser mecânico. Na concepção atual, Talos poderia, também, ser visto como um ciborgue.

Morte de Talos. In: Adrienne Mayor, Gods and Robots: Myths, Machines, and Ancient Dreams of Technology, 2018.

</Acréscimo versão 2019>

No século XVIII, os autômatos fizeram parte não só do imaginário humano, mas, também, foram postos em prática. Principalmente através das mãos habilidosas do inventor francês Jacques de Vaucanson:

Nessa aula, iremos um pouco além. Vamos falar da junção, de fato, dos homens com as máquinas. Iremos conversar sobre ciborgues!

Embora as discussões sobre o tema tenham surgido ainda na década de 1940, foi nos anos 1960 que a ideia de máquinas e organismos interagindo em novas formas ganhou fôlego. As máquinas podiam ser vistas de duas formas:

1) ciborgues (cybernetic organism, organismo cibernético) – máquina como parte dos organismos biológicos existentes, ou seja, a modificação maquinária podia ajudar um animal (e homens) a sobreviver e a operar em ambientes hostis, tais como espaço sideral e profundezas de oceanos;

2) máquinas vivas sem base orgânica – máquinas sem tecidos com características de seres vivos, ou seja, com habilidade para reprodução, mutação, evolução, e pensamento.

Algumas das questões sobre máquinas como seres vivos foram discutidas entre Wiener e John von Neumann na década de 1940, enquanto Neumann trabalhava no ENIAC (Eletronic Numerical Integrator and Calculator) dentro da Universidade da Pensilvânia. Por volta de 1946, Neumann sentiu que o cérebro humano era simplesmente muito complexo para ser estudado como um modelo para computadores: ele sugeriu que era necessário estudar seres mais simples, como os vírus. Em uma série de palestras intitulada Theory of Self-Reproducing Automata (publicadas em 1966), Neumann deliberadamente pulou de uma descrição das máquinas em termos orgânicos para uma descrição de seres vivos em termos mecânicos. Porém, para ele, a reprodução, de um ponto de vista mecânico, levava a uma conclusão oposta: auto reprodução orgânica era evolutiva; auto reprodução mecânica era degenerativa: uma máquina elaborada para fazer outras máquinas deve conter seus próprios componentes, o design da nova máquina, e as partes e ferramentas para montar a nova máquina, ou seja, a máquina “pai” era construída para ser mais complexa do que a máquina “filho”. Segundo Neumann, para uma máquina poder construir outra de mesma complexidade, ela teria de ter as seguintes partes: órgão estimulante, órgão de fusão (para soldar as partes), órgão de cortes (para dessoldar partes), e um músculo para produzir movimentação.

J. C. R. Licklider, cientista da computação estadunidense e um dos pioneiros da internet, via os problemas de comando e controle como essencialmente problemas de interação homem-computador. Licklider não queria delegar cada vez mais decisões autoritárias às máquinas: para ele, homem e máquina não estavam em competição – eles complementavam um ao outro, gerando uma simbiose homem-máquina (ideia articulada no artigo Man-Computer Symbiosis, de 1960), tornando humanos e computadores estreitamente ligados. Contudo, três problemas tinham de ser resolvidos para a simbiose acontecer:

1) compartilhamento de tempo – divisão de recursos de processamento de supercomputadores caros entre um número de usuários humanos;

2) aperfeiçoamento das limitações das interfaces input-output dos computadores;

3) velocidade de armazenamento e acesso a grandes quantidades de dados e informações – para Licklider, interfaces gráficas e reconhecimento de voz seriam altamente desejáveis.

Em 1962, Licklider começou a trabalhar na Pentagon’s Advanced Research Projects Agency (ARPA), continuando seu trabalho de aperfeiçoamento da comunicação homem-máquina: para ele, a única solução era uma rede de computadores interligados (algo que só foi realizado quase 20 anos após, com a internet).

O primeiro ciborgue, contudo, nasceu em maio de 1960, no Texas, no hospital da Randolph Air Force Base como um desafio para voar em novas altitudes. O doutor Nathan Kline e o engenheiro Manfred Clynes publicaram um artigo intitulado Drugs, Space and Cybernetics: Evolution to Cyborgs nesse ano sobre a teoria do controle automático de sistemas ao corpo humano (ciborgue). A ideia básica do ciborgue era intuitiva: na Terra, a maioria das funções regulatórias do corpo funcionam (não temos de lembrar de ajustar nossa pressão sanguínea ou como respirar) – o objetivo, então, era emular esse comportamento automático e inconsciente no espaço sideral, liberando, assim, o astronauta das limitações do corpo humano. Para tanto, podiam ser implantados organismos artificiais no corpo humano para regular os inputs, e drogas podiam ser injetadas para auxiliar na regulagem. As ideias, contudo, não deixaram o papel, mesmo com a NASA (fundada em 1958) levando em consideração tais estudos.

O ciborgue, contudo, não possuía usos apenas no espaço. Na Terra, os militares também começaram a pesquisar o assunto. Ralph Mosher, engenheiro da General Electric, conseguiu milhões de dólares em financiamentos para a junção homem-máquina trabalhando para as Forças Armadas estadunidenses. Para Mosher, faltava algo relevante na relação com as máquinas: o feedback. Ele entendeu que o sentido cinestésico das forças dos ossos e músculos importava – isso gerava uma máquina cibernética antropomorfa (cybernetic anthropomorphus machine, CAM). Mosher chamou sua primeira CAM de Handyman: formada por um par de poderosos braços mecânicos, ligeiramente maiores do que os humanos, mas com estrutura similar (juntas de cotovelos e garras de dois dedos), que podiam efetuar 10 movimentos em um espaço tridimensional – essas ferramentas ficavam em uma caixa preta na frente do aparato e eram alimentadas por cabos hidráulicos. As garras hidráulicas imitavam as ações dos braços e mãos de um homem, e ele, em contrapartida, sentia o feedback das garras por meio de sensores. Com a Guerra do Vietnã, Mosher pôde trabalhar junto ao exército na construção de CAMs para caminharem nos ambientes hostis das selvas. Em 1964, o Pedipulator (ver vídeo abaixo) foi construído: a máquina bípede parecia um AT-ST do filme Star Wars – uma cabine com uma grande janela frontal sustentada sobre duas pernas finas com quase 6 metros de altura. Para Mosher, os mecanismos cibernéticos tinham grande vantagem sobre os veículos convencionais: uma integração efetiva homem-máquina eliminava alavancas e pedais de freio, fazia a programação ser obsoleta, requeria pouco treino, seu feedback de força reduzia riscos, e máquinas cibernéticas podiam deixar os operadores livres para focar nos problemas que se apresentassem. Embora impressionasse as Forças Armadas, o Pedipulator gerou a preocupação sobre como ele se colocaria de pé caso caísse no terreno: a solução, então, foi desenvolver uma máquina quadrúpede – porém, ele se mostrou bastante difícil de ser controlado pelos operadores mesmo após treinamento. Somente uma máquina caminhante cibernética foi construída para o exército antes de o programa ser descontinuado. Para Mosher, havia uma diferença sutil entre controle humano e controle automático: uma simples pá usada em jardinagem era uma CAM pois estendia o corpo humano e seus sentidos e podia ser usada sem treinamento, tornando-se parte do corpo do operador (pois, ao contrário de um guindaste, a pá fornecia sentido de força, superfície, posição, velocidade e direção).

Em novembro de 1965, a GE lançou um exoesqueleto completamente funcional para cargas pesadas muito semelhante ao que James Cameron apresentaria no filme Aliens, em 1986. Denominado Hardiman (“man” sendo abreviação de “manipulator”), ele foi construído a fim de lidar com cargas pesadas em situações extremas: carregamento de bombas em asas de aviões de caça, construção subaquática, e trabalho manual em viagens no espaço. O Hardiman, contudo, teve o projeto cancelado em 1968 porque os militares não estavam convencidos de sua viabilidade. Mosher, porém, nessa época já dizia que não era necessário ter um operador dentro da CAM: o aparato podia ser controlado remotamente.

Desse modo, vimos que ciborgues são uma realidade e, se for adepto das ideias de Donna Haraway (A Cyborg Manifest, 1985), você também é um ciborgue: a utilização de ferramentas estende a nossa capacidade de atuação no mundo e, também, utilizamos máquinas cibernéticas em nosso cotidiano, em uma simbiose. É uma visão um pouco diferente daquelas encontradas em filmes ou obras de ficção científica, não é? Por exemplo, os borgs do Star Trek: a Nova Geração não são bem aquilo que foi mostrado aqui:

<Acréscimo versão 2019>

Aposto que bateu curiosidade para saber como são os ciborgues do século XXI, não foi? Esse vídeo do The Guardian é incrível! Recomendo vê-lo inteiro:

</Acréscimo versão 2019>

Leitura recomendada

› RID, Thomas. Rise of the machines. A cybernetic history. New York: W. W. Norton & Company, Inc., 2016.

O capítulo 4, intitulado “Organims”, oferece um panorama sobre o ciborguismo e foi usado de base para essa aula.

› MAYOR, Adrienne. Gods and Robots: Myths, Machines, and Ancient Dreams of Technology, 2018.

A Introdução e o primeiro capítulo são realmente interessantes para se ter uma ideia de como os mitos antigos podem se relacionar com nossas ideias de robôs e ciborgues.

› NEUMANN, Jon von. Theory of self-reproducing automata. Urbana/London: University of Illinois Press, 1966.

A série de palestras de Neumann sobre a reprodução das máquinas. Pesadão.

› CLYNES, Manfred E. & KLINE, Nathan S. “Cyborgs and space”. In: Astronautics, september, 1960.

O famoso artigo sobre a invenção do ciborgue.

› LICKLIDER, J. C. R. “Man-computer symbiosis”. In: IRE Transactions on Human Factors in Electronics (1), 1960 , pp. 4-11.

Artigo curto e excelente de Licklider sobre a simbiose homem-máquina. Fundamental.

› KLINE, Ronald. “Where are the cyborgs in cybernetics?”. In: Social Studies in Science (39), 2009 , pp. 331-362.

Esse não é o Kline do artigo clássico de 1960. Nesse texto, há um apanhado da história do ciborguismo e seus estudos atuais.

Jogo recomendado

Jogos com ciborgues são muitos. Um dos mais divertidos, porém, é o Far Cry 3: Blood Dragon, lançado pela Ubisoft em 2013. Você é um soldado com implantes que precisa destruir tudo pelo caminho (o clima de anos 80 é memorável!). Um dos melhores jogos que já experienciei.

Você pode adquirir na Steam: Acesse.

Filme recomendado

Ghost in the Shell (1995) é a adaptação do mangá de Shirow Masamune. Nem vou falar mais nada.

Aula 5 (Teoria) – LSD ou Realidade Virtual? Drogas e virtualização do espaço afetando a consciência humana – um panorama

<Acréscimo versão 2019>

Antes de começarmos, um poema escrito por Richard Brautigan, em 1967, dentro do contexto da Contracultura estadunidense, sobre a relação entre Cibernética e Natureza.

Todos assistidos por máquinas de adorável graça

Eu gosto de imaginar (e

quanto antes melhor!)

uma campina cibernética

onde mamíferos e computadores

vivem juntos em harmonia

mutuamente programada

como água pura

tocando o céu claro.

Eu gosto de imaginar

(agora, por favor!)

uma floresta cibernética

cheia de pinheiros e eletrônicos

onde cervos perambulam em tranquilidade

passando por computadores

como se eles fossem flores

em desabrochar giratório.

Eu gosto de imaginar

(e tem que existir!)

uma ecologia cibernética

onde estamos todos livres dos nossos trabalhos

e unidos novamente à natureza,

retornados aos mamíferos

nossos irmãos e irmãs

todos assistidos

por máquinas de adorável graça.

(In: Rafael Evangelista. Para além das máquinas de adorável graça: cultura hacker, cibernética e democracia. São Paulo: Edições Sesc, 2018)

</Acréscimo versão 2019>

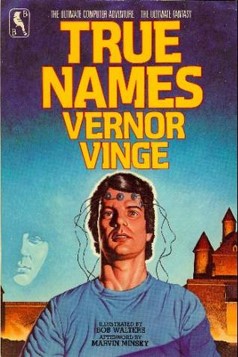

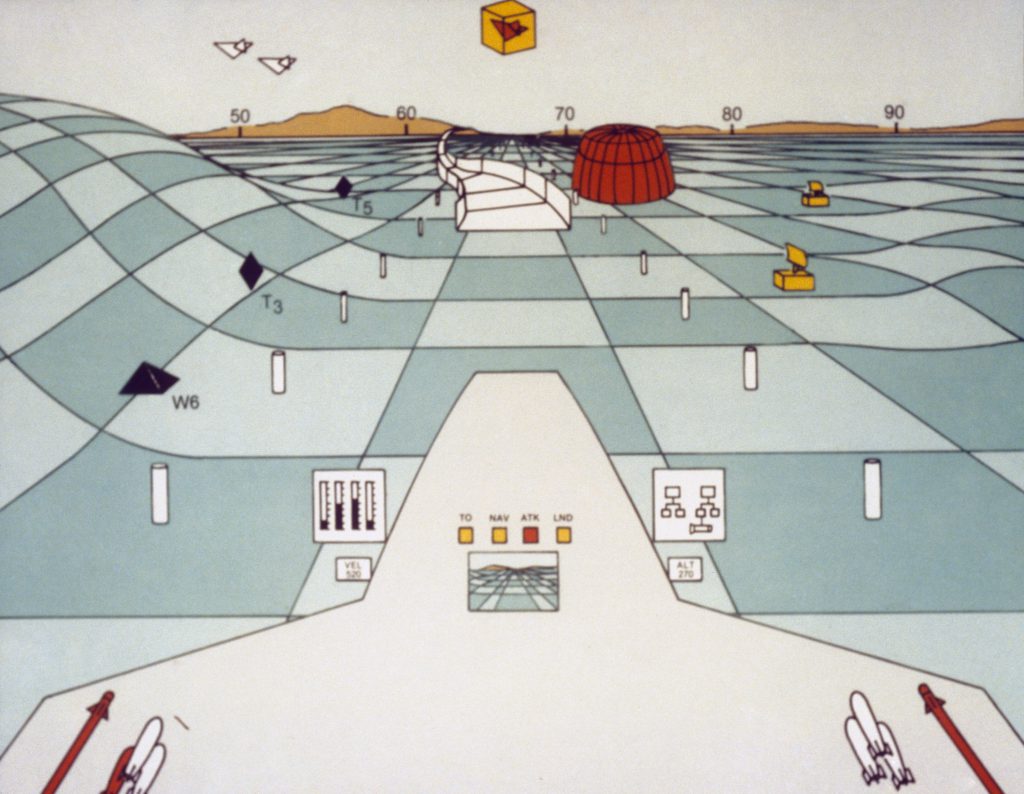

Não demorou muito para a Cibernética adentrar outros campos que não fossem os acadêmicos. Isso acabou refletido em três vertentes principais de exploração de ideias: 1) a cibernética de “auto-ajuda”; 2) a cibernética da contracultura estadunidense; e 3) a cibernética de ficção científica.